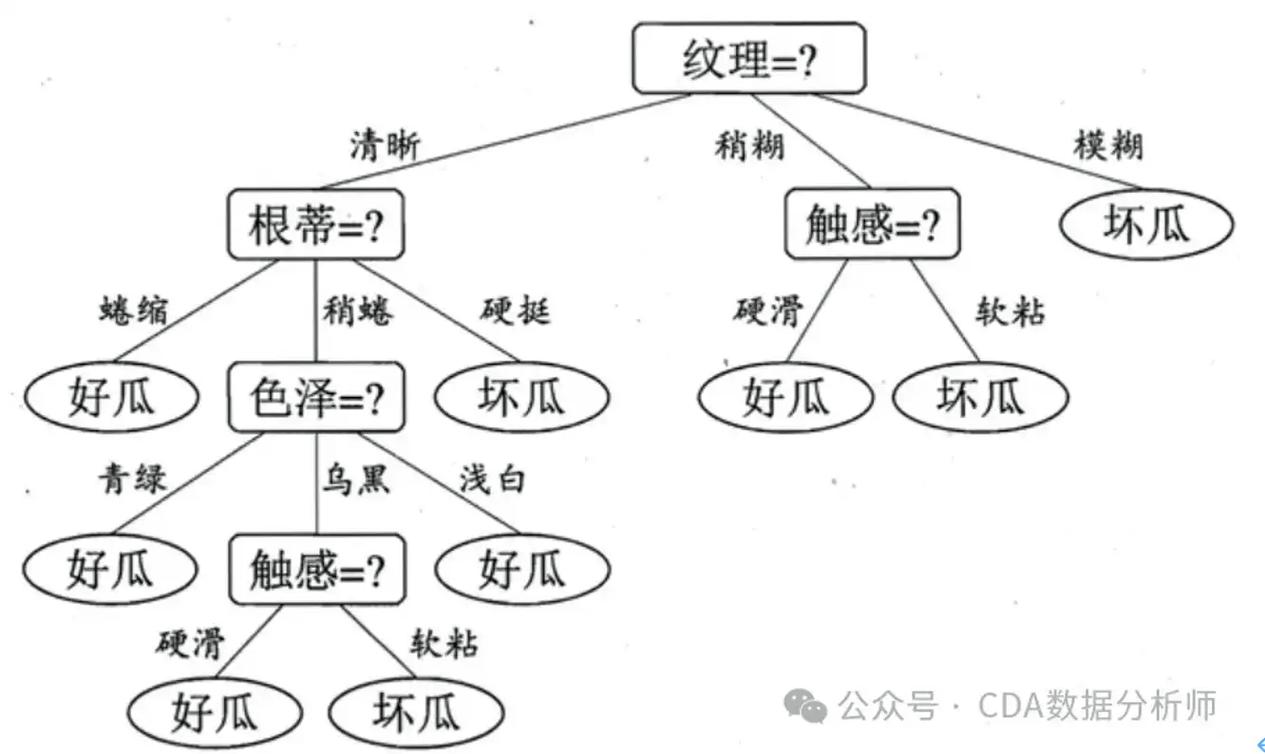

机器学习中的决策树是一种非常流行的监督学习算法,它通过一系列规则对数据进行分类或回归。决策树算法的基本思想是,根据数据特征对数据进行分割,使得分割后的数据尽可能“纯净”,即属于同一类的样本尽可能多地聚集在一起。下面我将详细介绍决策树算法的基本概念、原理和应用。

基本概念

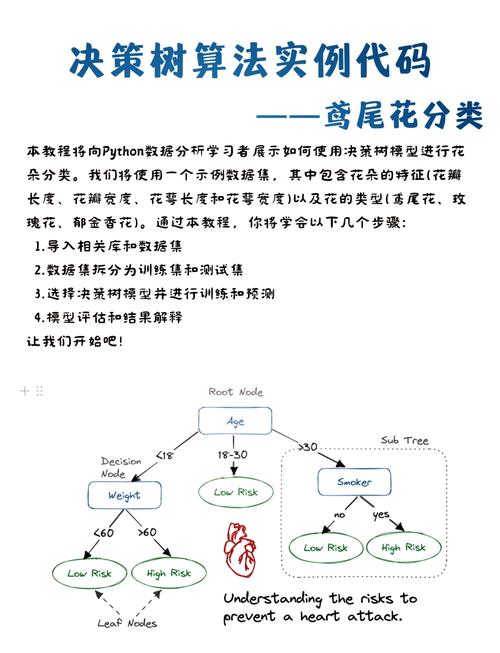

1. 节点(Node):树中的每个节点都代表一个特征或者属性。2. 叶节点(Leaf Node):树的末端节点,不再进行分割,表示一个类别或者预测值。3. 决策节点(Decision Node):除了叶节点之外的节点,代表一个决策规则。4. 路径(Path):从根节点到叶节点的路径,表示一个决策过程。5. 树深度(Depth):从根节点到最远叶节点的路径长度。6. 树宽度(Width):树中所有叶节点的最大宽度。

决策树原理

决策树算法通过递归地选择最优特征进行分割,直到满足停止条件。最优特征的选择通常基于某个评估指标,如信息增益、增益率或基尼指数等。以下是决策树算法的基本步骤:

1. 选择最优特征:根据评估指标,选择能够最大化分割效果的属性作为当前节点的决策特征。2. 分割数据:根据选择的特征和阈值,将数据集分割成两个子集。3. 递归分割:对每个子集重复步骤1和2,直到满足停止条件。4. 停止条件:通常包括以下几种情况: 子集的样本数量小于某个阈值。 所有样本属于同一类别。 达到最大树深度。

决策树应用

决策树算法在许多领域都有广泛的应用,如:

1. 分类问题:根据特征对数据进行分类,如垃圾邮件过滤、疾病诊断等。2. 回归问题:根据特征预测连续值,如房价预测、股票价格预测等。3. 特征选择:通过决策树算法可以识别出对分类或回归任务影响最大的特征。4. 数据可视化:决策树的结构可以直观地展示数据的分布和特征之间的关系。

决策树优缺点

优点:

1. 易于理解和解释:决策树的结构简单,易于理解,可以直观地展示决策过程。2. 适用于处理不完整数据:决策树算法可以处理缺失值,通过忽略缺失特征或者使用平均值等方法。3. 适用于多分类问题:决策树可以处理多分类问题,通过在叶节点设置多个类别或者使用集成方法等。

缺点:

1. 容易过拟合:决策树算法容易对训练数据进行过拟合,导致泛化能力差。2. 对噪声敏感:决策树对噪声数据比较敏感,容易导致决策规则的不稳定。3. 树的深度和宽度难以控制:决策树的深度和宽度可能过大,导致训练时间和内存消耗增加。

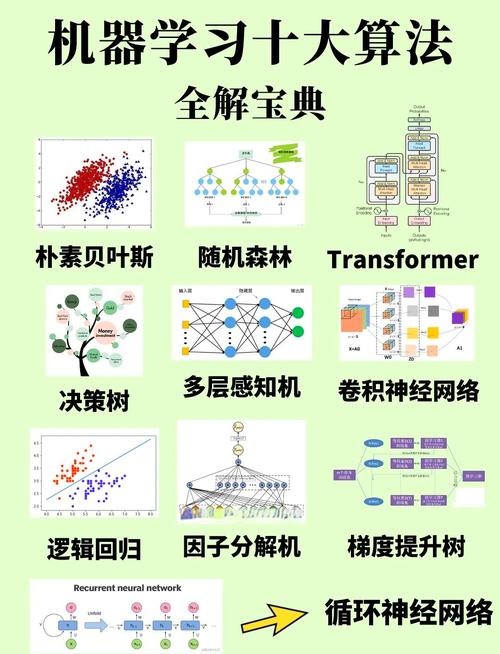

为了解决决策树的过拟合问题,通常采用剪枝、集成等方法。剪枝通过删除不必要的节点来减少树的复杂度,提高泛化能力。集成方法,如随机森林和梯度提升树等,通过构建多个决策树并取平均值来提高预测的准确性和稳定性。

总之,决策树是一种简单、有效且应用广泛的机器学习算法,它通过递归地选择最优特征进行分割,直到满足停止条件。决策树算法在分类、回归、特征选择和数据可视化等方面都有广泛的应用。决策树也容易过拟合,对噪声敏感,树的深度和宽度难以控制。为了解决这些问题,通常采用剪枝、集成等方法。

深入解析机器学习中的决策树算法

一、决策树的基本概念

决策树是一种基于树形结构的数据挖掘方法,通过一系列规则对数据进行分割,最终形成树状结构。决策树的每个节点代表一个特征,每个分支代表一个决策规则,叶节点代表最终的预测结果。

二、决策树的构建过程

决策树的构建过程主要包括以下步骤:

选择最优特征:根据信息增益、基尼指数等指标,选择对当前数据集最具区分度的特征。

划分数据集:根据所选特征,将数据集划分为若干个子集。

递归构建子树:对每个子集重复步骤1和2,直到满足停止条件(如所有子节点属于同一类别)。

在构建过程中,常用的评价指标包括信息增益、基尼指数、卡方检验等。信息增益表示特征对数据集的区分度,基尼指数表示数据集的不纯度,卡方检验则用于比较特征与目标变量之间的相关性。

三、决策树的应用场景

决策树算法在以下场景中具有较好的应用效果:

分类任务:如邮件分类、垃圾邮件检测、疾病诊断等。

回归任务:如房价预测、股票价格预测等。

特征选择:通过决策树可以识别出对预测结果影响较大的特征。

此外,决策树还可以与其他机器学习算法结合,如随机森林、梯度提升树等,进一步提高预测准确率。

四、决策树的优缺点

决策树算法具有以下优点:

简单易懂:决策树的结构直观,易于理解和解释。

可解释性强:决策树可以清晰地展示预测过程,便于分析。

对噪声数据鲁棒:决策树对噪声数据具有较强的鲁棒性。

决策树算法也存在一些缺点:

过拟合:当决策树过于复杂时,容易发生过拟合现象。

计算效率低:决策树的构建和预测过程需要较大的计算资源。

对缺失值敏感:当数据集中存在缺失值时,决策树算法可能无法正确预测。

为了解决这些问题,可以采用剪枝、集成学习等方法对决策树进行优化。

决策树作为一种经典的机器学习算法,在分类和回归任务中具有广泛的应用。本文对决策树的基本概念、构建过程、应用场景以及优缺点进行了深入解析。在实际应用中,可以根据具体问题选择合适的决策树算法,并结合其他机器学习算法进行优化,以提高预测准确率。