1. 特征重要性:确定哪些特征对模型的预测结果影响最大。

2. 决策树可视化:使用决策树可视化工具来理解模型的决策过程。

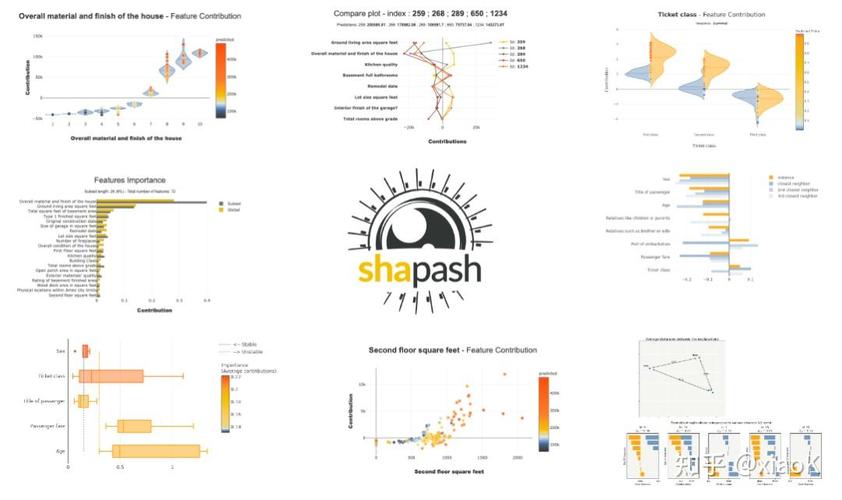

3. 模型解释工具:使用模型解释工具,如LIME和SHAP,来解释模型的预测结果。

4. 模型简化:通过简化模型来提高可解释性,例如使用决策树代替复杂的神经网络。

5. 特征选择:选择与预测目标最相关的特征,以减少模型复杂性并提高可解释性。

6. 透明度:提供关于模型训练过程、参数设置和性能指标的信息。

7. 人类可解释性:确保模型解释能够被非专业人士理解。

8. 模型对比:比较不同模型的预测结果和解释,以选择最合适的模型。

9. 模型验证:验证模型的预测结果和解释是否与实际相符。

10. 持续改进:不断收集用户反馈和数据,以改进模型的可解释性。

提高机器学习模型的可解释性有助于提高模型的信任度、可维护性和改进模型的性能。

机器学习可解释性:提升模型透明度和信任度

随着机器学习(ML)技术的飞速发展,其在各个领域的应用日益广泛。机器学习模型往往被视为“黑盒”,其决策过程难以解释,这限制了其在某些关键领域的应用。因此,机器学习可解释性成为了当前研究的热点。本文将探讨机器学习可解释性的重要性、挑战以及相关技术。

一、机器学习可解释性的重要性

1. 提高模型透明度

机器学习可解释性有助于用户理解模型的决策过程,从而提高模型的透明度。这对于需要解释其决策的领域,如医疗诊断、金融风险评估等,尤为重要。

2. 增强用户信任度

当用户能够理解模型的决策过程时,他们更有可能信任模型的结果。这对于提高机器学习技术在实际应用中的接受度至关重要。

3. 促进模型优化

通过分析模型的决策过程,可以发现模型中的潜在问题,从而促进模型的优化和改进。

二、机器学习可解释性的挑战

1. 模型复杂性

随着深度学习等复杂模型的兴起,模型的决策过程更加难以解释。如何解释这些复杂模型成为了可解释性研究的一大挑战。

2. 数据隐私

在处理敏感数据时,如何在不泄露隐私的前提下解释模型决策过程,也是一个重要问题。

3. 计算成本

可解释性技术往往需要额外的计算资源,如何在保证模型性能的同时降低计算成本,是一个需要解决的问题。

三、机器学习可解释性技术

1. 特征重要性

通过分析特征对模型输出的影响,可以评估特征的重要性。常用的方法包括特征重要性、Permutation Importance等。

2. 局部可解释性

3. 全局可解释性

全局可解释性技术旨在解释整个模型的决策过程。常用的方法包括决策树、规则提取等。

四、未来展望

1. 融合多种可解释性技术

未来研究可以探索将多种可解释性技术相结合,以更好地解释复杂模型的决策过程。

2. 发展高效的可解释性算法

随着机器学习模型的不断复杂化,如何开发高效的可解释性算法,是一个值得关注的方向。

3. 探索可解释性与隐私保护的结合

在保护数据隐私的前提下,如何实现模型的可解释性,是一个具有挑战性的研究方向。

通过本文的探讨,我们可以看到机器学习可解释性在提高模型透明度、增强用户信任度以及促进模型优化等方面具有重要意义。同时,我们也认识到机器学习可解释性面临着诸多挑战。未来,随着研究的不断深入,相信机器学习可解释性技术将取得更大的突破。