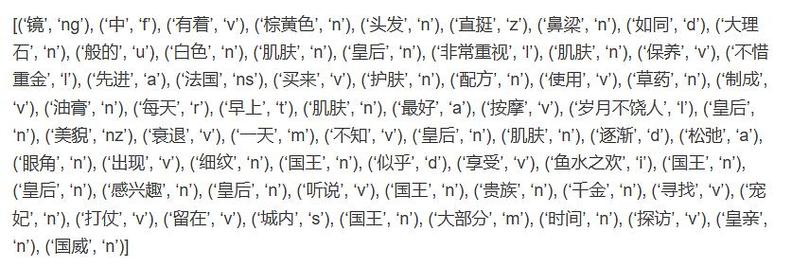

LDA(Latent Dirichlet Allocation)是一种文档主题生成模型,常用于文本挖掘、主题建模和信息检索等领域。LDA模型通过将文档表示为一组主题的概率分布,将主题表示为一组单词的概率分布,从而实现对文本数据的降维和主题提取。

LDA模型的基本思想是将每篇文档视为多个主题的混合,每个主题由多个单词组成。模型的目标是通过学习文档中每个主题的概率分布以及每个主题中每个单词的概率分布,来对文档进行主题建模。

LDA模型的训练过程主要包括以下步骤:

1. 初始化:为每个文档分配一个主题分布,为每个主题分配一个单词分布。2. 迭代更新:对于每个文档中的每个单词,根据当前的主题分布和单词分布,计算该单词属于每个主题的概率,然后根据概率选择一个主题。更新该文档的主题分布和该主题的单词分布。3. 重复迭代更新步骤,直到模型收敛。

LDA模型的参数主要包括:

K:主题的数量 α:文档主题分布的先验参数 β:主题单词分布的先验参数

LDA模型的优点在于其能够自动发现文档中的潜在主题,并且不需要人工干预。但是,LDA模型的训练过程比较复杂,需要大量的计算资源,并且在主题数量和先验参数的选择上需要进行一定的调优。

在机器学习中,LDA模型可以与其他模型相结合,例如分类、聚类等,以提高模型的性能。同时,LDA模型也可以应用于其他领域,例如图像处理、语音识别等,通过对数据进行降维和主题提取,来提高模型的效率和准确性。

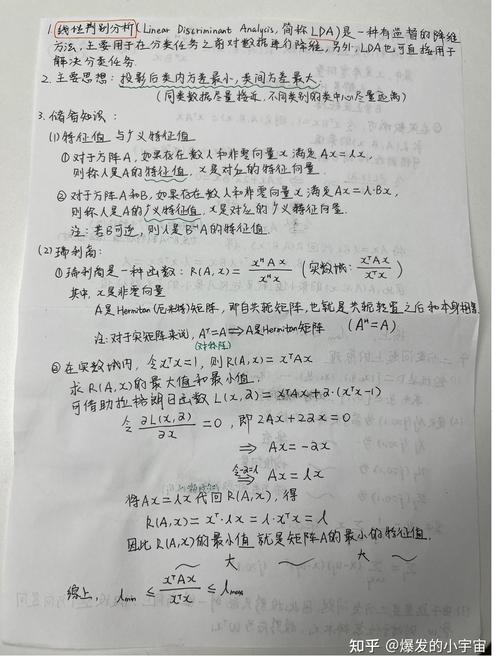

深入浅出线性判别分析(LDA):原理、应用与实现

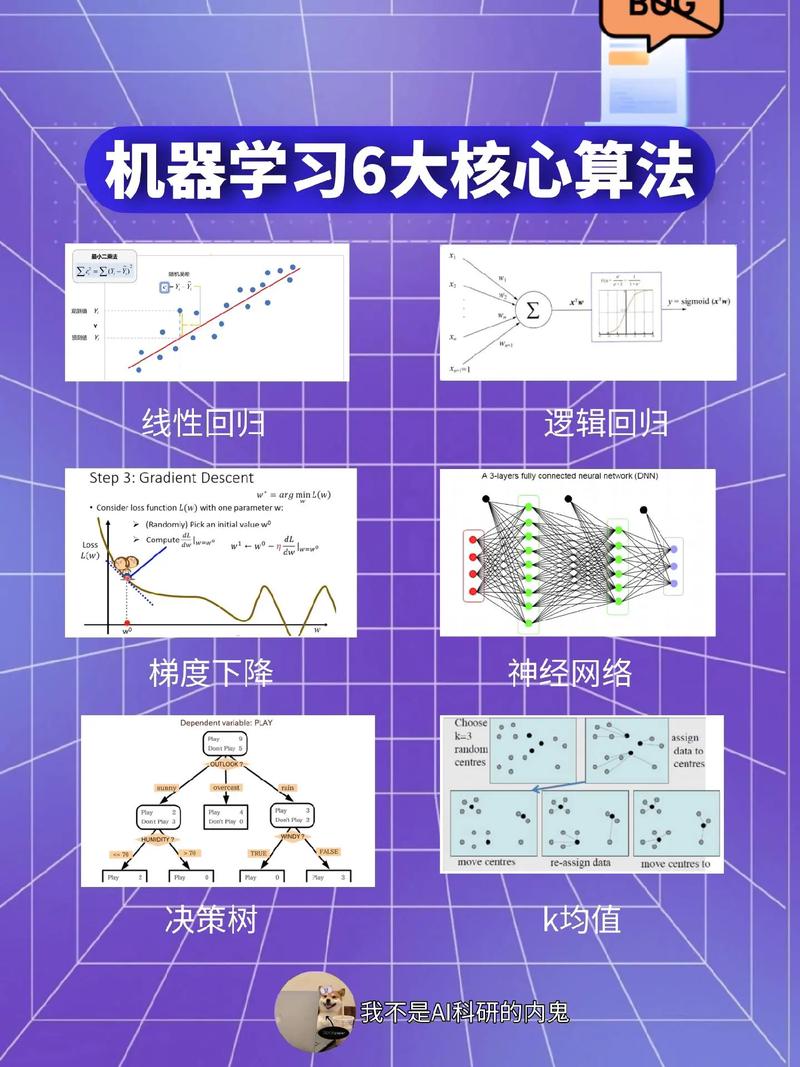

线性判别分析(Linear Discriminant Analysis,简称LDA)是一种经典的机器学习算法,主要用于特征降维和分类。本文将深入浅出地介绍LDA的原理、应用场景以及实现方法。

一、LDA的原理

LDA的基本思想是将数据投影到低维空间,使得同一类别的数据尽可能聚集在一起,而不同类别的数据尽可能分散。具体来说,LDA通过以下步骤实现这一目标:

计算每个类别的均值向量。

计算每个类别内样本与均值向量的距离,即类内散布矩阵。

计算所有类别之间的距离,即类间散布矩阵。

求解最优投影方向,使得投影后的类内散布矩阵最小,类间散布矩阵最大。

将数据投影到最优投影方向上,得到降维后的数据。

二、LDA的应用场景

LDA在以下场景中具有广泛的应用:

特征降维:在高维数据集中,LDA可以帮助我们找到最重要的特征,从而降低数据的维度,提高计算效率。

分类:LDA可以将数据投影到低维空间,使得同类数据更加聚集,从而提高分类的准确性。

聚类:LDA可以帮助我们找到数据中的潜在结构,从而进行聚类分析。

三、LDA的实现方法

LDA的实现方法主要有以下几种:

Python:使用scikit-learn库中的LDA类进行实现。

R:使用lda包进行实现。

Matlab:使用Statistics and Machine Learning Toolbox中的lda函数进行实现。

四、LDA的优缺点

LDA的优点如下:

原理简单,易于理解。

计算效率高,适用于大规模数据集。

能够有效地降低数据维度。

LDA的缺点如下:

对异常值敏感,容易受到噪声的影响。

假设数据服从正态分布,实际应用中可能不满足这一假设。

五、LDA的应用案例

以下是一个使用LDA进行鸢尾花分类的案例:

导入鸢尾花数据集。

使用LDA进行特征降维。

使用降维后的数据进行分类。

评估分类效果。

线性判别分析(LDA)是一种经典的机器学习算法,具有原理简单、计算效率高、能够有效地降低数据维度等优点。在实际应用中,LDA可以用于特征降维、分类和聚类等多个方面。LDA也存在一些缺点,如对异常值敏感、假设数据服从正态分布等。因此,在使用LDA之前,我们需要对数据进行分析,确保其满足LDA的假设条件。