机器学习中的聚类是一种无监督学习技术,用于将数据集中的对象分组,使得组内的对象彼此相似,而组间的对象彼此不同。聚类算法可以帮助我们识别数据中的模式,了解数据的内在结构,并应用于多种领域,如市场细分、社交网络分析、图像处理等。

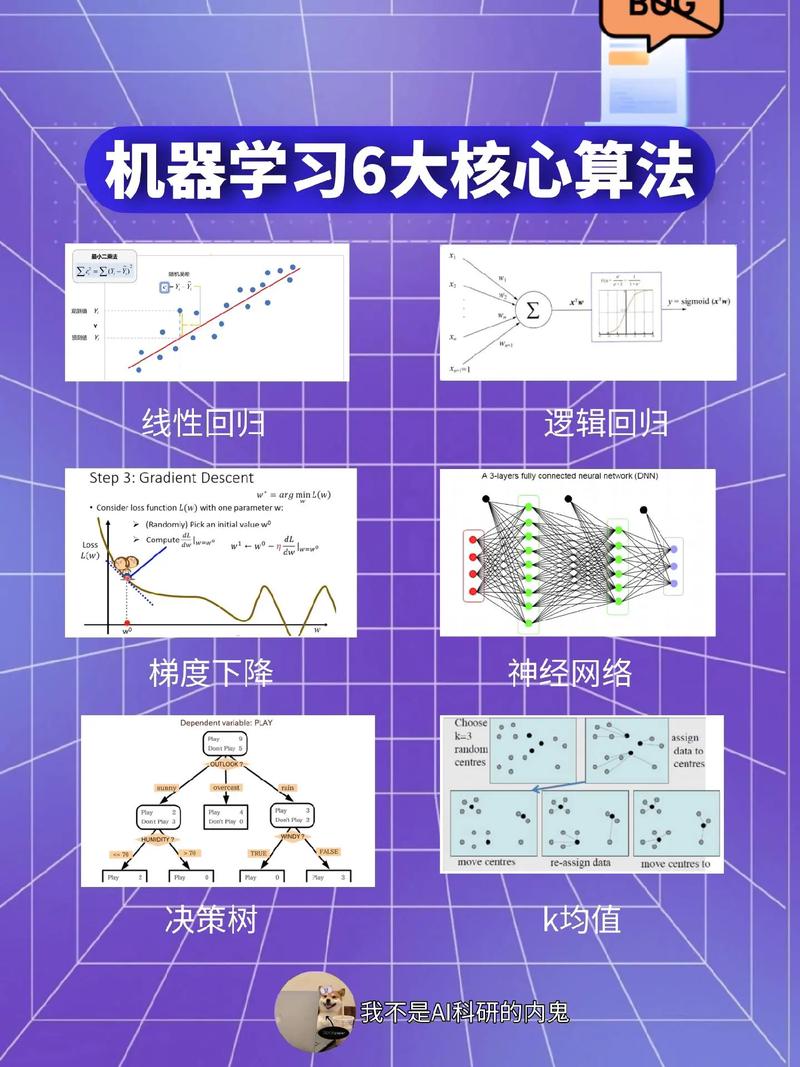

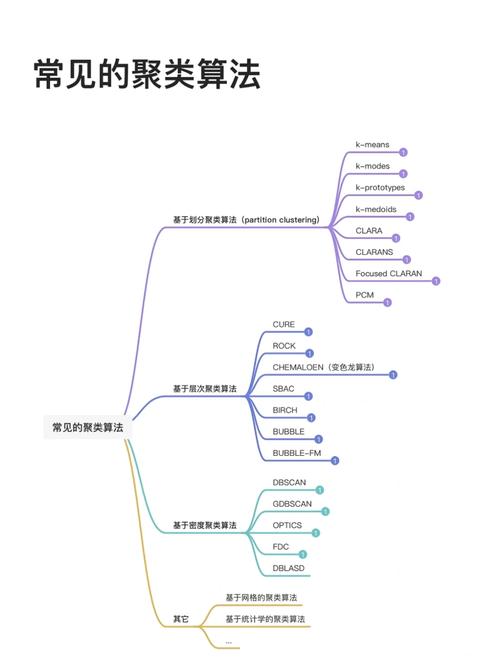

以下是几种常见的聚类算法:

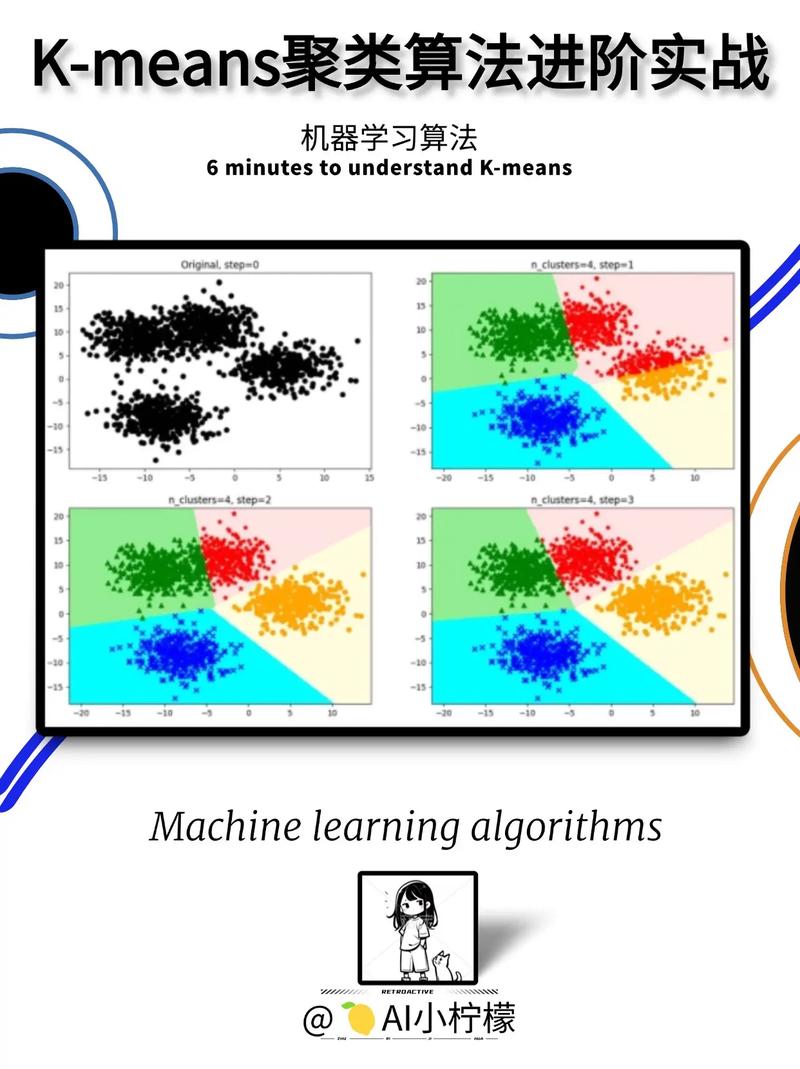

1. KMeans聚类: 原理:选择K个初始点作为质心,然后分配每个点到一个最近的质心,重新计算质心,重复这个过程直到质心不再变化。 优点:计算简单,易于实现。 缺点:对初始质心的选择敏感,可能陷入局部最优。

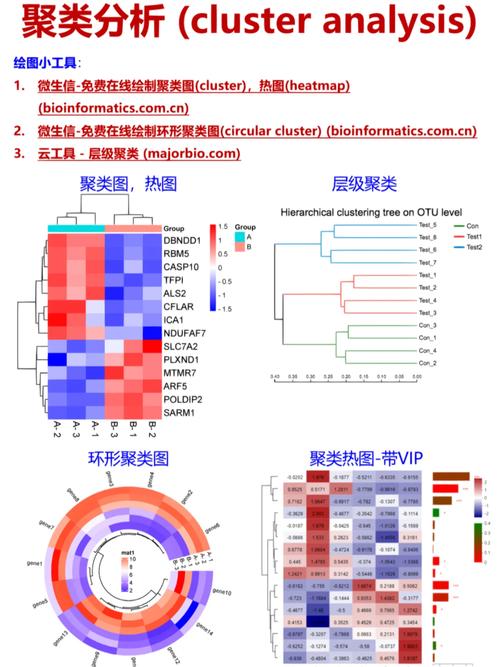

2. 层次聚类: 原理:通过构建一棵树来表示数据点的层次关系,可以生成不同粒度的聚类。 优点:可以生成层次化的聚类结果。 缺点:计算复杂度较高,不适合大规模数据集。

3. DBSCAN(DensityBased Spatial Clustering of Applications with Noise): 原理:基于密度的聚类,将数据点分为核心点、边界点和噪声点。 优点:可以处理任意形状的聚类,对噪声和异常值有较好的鲁棒性。 缺点:参数选择对结果影响较大。

4. 谱聚类: 原理:利用数据点的邻接矩阵来构建相似性矩阵,通过谱分析找到数据的低维表示,进而进行聚类。 优点:可以处理非欧几里得空间的数据,适用于高维数据。 缺点:计算复杂度较高,对参数选择敏感。

在实际应用中,选择合适的聚类算法需要考虑数据的特征、聚类的目的以及计算资源等因素。同时,聚类算法的结果往往依赖于参数的选择,因此在应用过程中需要进行适当的参数调整和评估。

深入解析机器学习中的聚类分析:原理、应用与挑战

聚类分析是机器学习领域中的一种无监督学习方法,它通过挖掘数据中的内在结构和规律,将数据对象自动划分为多个类别或簇。本文将深入探讨聚类分析的基本原理、应用场景以及面临的挑战。

一、聚类分析的基本原理

聚类分析的核心思想是将相似的数据点归为一类,而将不同类的数据点区分开来。在聚类分析中,通常使用距离度量来衡量数据点之间的相似性。常见的距离度量方法包括欧几里得距离、曼哈顿距离等。

二、K-means聚类算法

在众多聚类算法中,K-means算法因其简单高效而备受青睐。K-means算法的基本思想是:通过迭代的方式,将数据划分为K个不同的簇,并使得每个簇内数据点的相似性最大化,而簇间的相似性最小化。

1. 算法原理

目标函数:K-means的目标是最小化以下目标函数:

k:簇的数量。

C:第 i 个簇的集合。

μ:第 i 个簇的中心(质心)。

d(x, μ):样本点 x 到质心 μ 的欧几里得距离。

步骤:

初始化:随机选择K个初始质心。

分配样本点到最近的质心:将每个样本点分配到最近的簇中心,形成K个簇。

更新质心:计算每个簇中所有样本点的均值,作为新的簇中心。

迭代:重复步骤2和3,直到簇中心不再发生显著变化或达到预设迭代次数。

三、K-means算法的特点

1. 优点:

简单高效:算法容易理解和实现,适合中小型数据集。

快速收敛:在大多数情况下,K-means收敛速度较快。

2. 缺点:

需要指定K:聚类数K需要预先指定,可能难以确定。

易受初始点影响:初始质心的选择可能导致不同的聚类结果。

对异常值敏感:异常点可能显著影响簇中心的位置。

仅适用于凸簇:不能有效处理非凸形状的簇。

四、聚类分析的应用场景

聚类分析在许多领域都有着广泛的应用,以下列举一些常见的应用场景:

市场细分:通过聚类分析,企业可以更好地了解客户需求,制定更精准的营销策略。

图像处理:聚类分析可以用于图像分割、颜色量化等任务。

生物信息学:聚类分析可以用于基因表达数据的分析,揭示基因之间的相互作用关系。

社交网络分析:聚类分析可以用于识别社交网络中的紧密联系群体。

五、聚类分析面临的挑战

1. 聚类不平衡问题:在现实世界中,数据往往存在不平衡现象,这可能导致聚类结果不准确。

2. 高维数据与维度灾难:高维数据中,数据点之间的距离度量变得困难,容易导致聚类结果不佳。

3. 初始质心的选择:初始质心的选择对聚类结果有较大影响,如何选择合适的初始质心是一个挑战。

聚类分析是机器学习领域中一种重要的无监督学习方法,具有广泛的应用前景。在实际应用中,我们还需要面对各种挑战,如聚类不平衡、高维数据等。通过不断优化算法和改进方法,我们可以更好地发挥聚类分析在各个领域的应用价值。