大数据资料收集方法

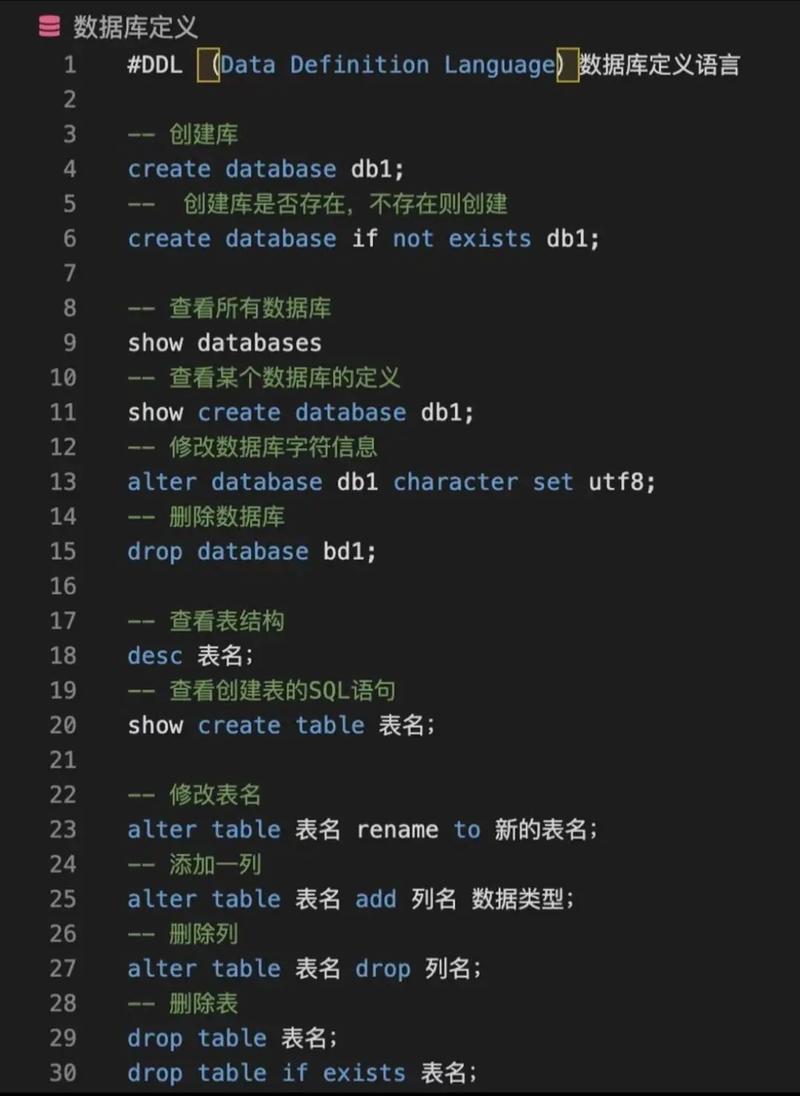

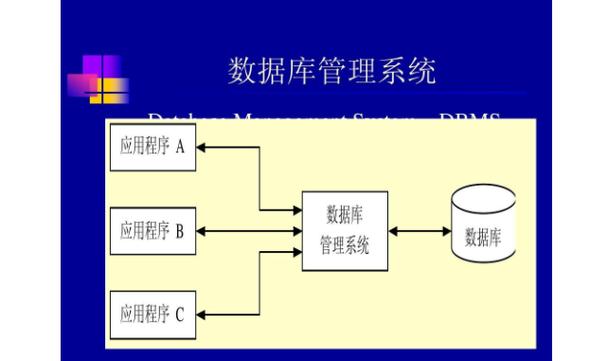

1. 数据库采集: 传统企业使用关系型数据库(如MySQL和Oracle)存储数据。 随着大数据时代的到来,NoSQL数据库(如Redis、MongoDB和HBase)也常用于数据采集。

2. 日志数据采集: 通过收集服务器、应用程序和网络设备的日志文件来获取数据。

3. 传感器数据采集: 来自物联网设备、监控系统的数据。

4. 社交媒体数据采集: 来自Facebook、Twitter、LinkedIn等社交平台的用户生成内容。

5. 交易数据采集: 来自电子商务平台、金融系统的交易记录。

6. 开放数据采集: 利用网络上的公开数据集,如开放数据平台提供的数据。

大数据资料收集工具

1. Apache Flume: 用于高效地收集、聚合和传输日志数据。

2. Apache Kafka: 高吞吐量的分布式消息队列系统,用于处理实时数据流。

3. 八爪鱼: 一款免费的网页爬虫工具,无需编码即可从许多网站抓取数据。

4. 亮数据: 一款强大的数据采集工具,以其全球代理IP网络和强大数据采集技术而闻名。

5. Scribe: Facebook开源的分布式日志收集系统,用于将各个需要统计的数据源收集到Cassandra中。

大数据资料收集最佳实践

1. 明确数据收集目标: 确定需要收集的数据类型和用途,避免数据收集的混乱和无效。

2. 使用合适的数据存储解决方案: 根据数据类型和规模选择合适的存储解决方案,如数据湖或数据仓库。

3. 确保数据质量和一致性: 在数据收集过程中,确保数据的准确性和一致性,避免数据损坏或丢失。

4. 数据安全与合规: 在收集和使用数据时,遵守相关的法律法规,确保数据安全。

5. 持续优化数据收集流程: 定期评估和优化数据收集流程,以提高效率和准确性。

通过以上方法、工具和实践,可以有效地进行大数据资料收集,为后续的数据分析和应用提供坚实的基础。

大数据资料收集的重要性

在当今信息爆炸的时代,大数据已经成为企业、政府和科研机构的重要资源。大数据资料收集是挖掘这些资源的第一步,它对于决策制定、市场分析、科学研究等领域具有至关重要的作用。

数据来源概述

网络公开数据集:如政府公开数据、社交媒体数据、在线论坛数据等。

数据报采集:通过数据报收集器从网络中抓取数据。

网络爬虫:利用爬虫技术自动从互联网上抓取数据。

日志收集:从服务器日志、应用程序日志等收集数据。

社会调查:通过问卷调查、访谈等方式收集数据。

业务数据集:企业内部产生的业务数据,如销售数据、客户数据等。

埋点采集:在网站或应用程序中埋设代码,收集用户行为数据。

传感器采集:从各种传感器设备中收集数据,如气象站、交通监控等。

数据交易平台:通过数据交易平台购买或交换数据。

个人数据收集:通过合法途径收集个人数据,如用户注册信息、消费记录等。

数据收集方法

针对不同的数据来源,以下是几种常见的大数据资料收集方法:

网络爬虫技术:通过编写爬虫程序,自动从互联网上抓取数据。

API接口调用:利用数据提供方的API接口,获取数据。

数据抓包:使用抓包工具,从网络传输过程中捕获数据。

问卷调查:通过设计问卷,收集用户反馈信息。

访谈法:与相关人员面对面交流,获取数据。

数据挖掘:从大量数据中挖掘有价值的信息。

数据清洗:对收集到的数据进行清洗,去除无效或错误的数据。

数据整合:将来自不同来源的数据进行整合,形成统一的数据集。

数据收集过程中的注意事项

在大数据资料收集过程中,需要注意以下事项:

合法性:确保数据收集的合法性,遵守相关法律法规。

数据质量:保证数据的质量,避免数据错误或缺失。

数据安全:保护数据安全,防止数据泄露或被非法使用。

数据隐私:尊重个人隐私,避免收集敏感信息。

数据多样性:收集多种类型的数据,以便进行更全面的分析。

数据收集工具与平台

爬虫工具:如Scrapy、BeautifulSoup等。

数据抓包工具:如Wireshark、Fiddler等。

问卷调查平台:如问卷星、金数据等。

数据清洗工具:如Pandas、OpenRefine等。

数据整合工具:如Talend、Informatica等。

大数据资料收集是挖掘大数据价值的重要环节。通过合理的数据收集方法、工具和平台,我们可以获取到高质量的数据,为后续的数据分析和应用奠定基础。在数据收集过程中,要注重合法性、数据质量、数据安全和数据隐私等方面,确保数据的有效性和可靠性。