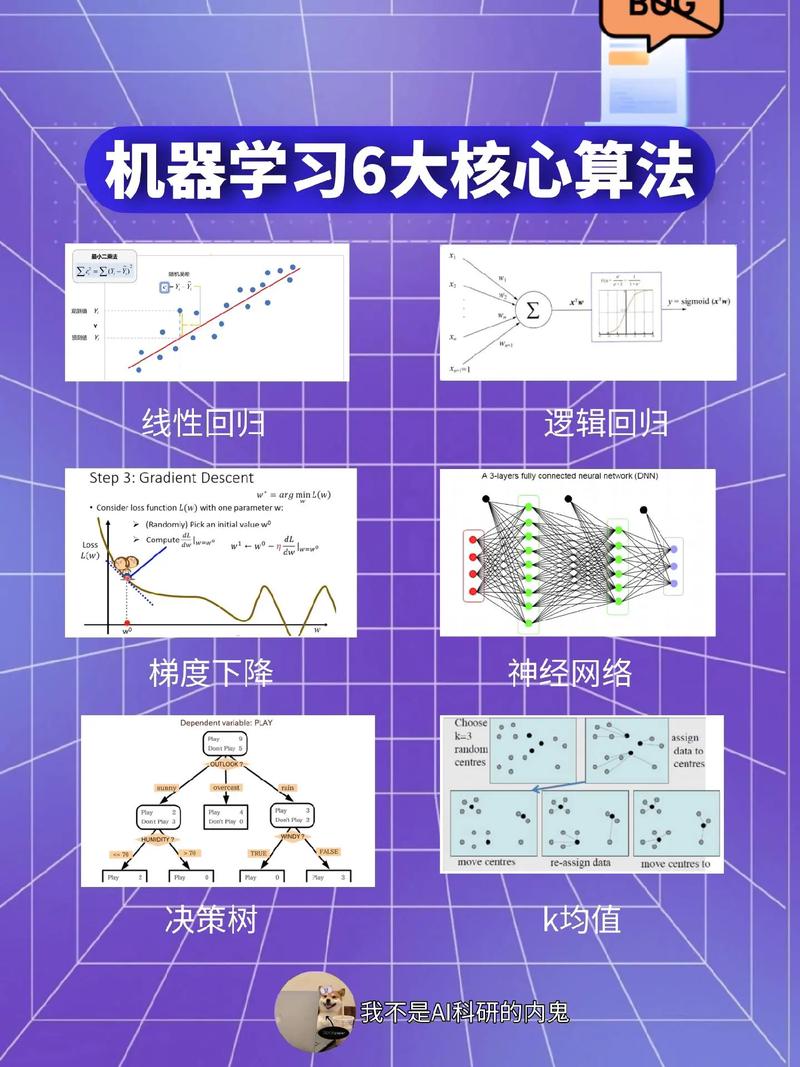

过学习(Overfitting)是机器学习中的一个重要概念,它描述了模型在训练数据上表现得非常好,但在新数据上表现不佳的情况。具体来说,过学习指的是模型过于复杂,捕捉了训练数据中的噪声和随机波动,而不是数据的真实规律。这导致模型在训练集上取得了很高的准确率,但在测试集或实际应用中却效果不佳。

过学习的原因通常是因为模型具有过多的参数或层次结构,使得它能够拟合训练数据中的每一个细节,包括那些非本质的噪声。当模型过度拟合时,它失去了泛化能力,即无法从训练数据中学习到可应用于新数据的普遍规律。

为了防止过学习,通常采用以下几种策略:

1. 正则化(Regularization):通过添加惩罚项来限制模型的复杂度,从而防止模型过度拟合。常见的正则化方法包括L1正则化(Lasso)、L2正则化(Ridge)和弹性网络(Elastic Net)。

2. 交叉验证(Crossvalidation):通过将数据集分为训练集、验证集和测试集,使用交叉验证来评估模型的泛化能力。通过在多个不同的数据子集上训练和验证模型,可以更准确地评估模型的性能。

3. 提取特征(Feature extraction):通过提取数据的本质特征,减少模型需要学习的参数数量,从而降低过学习的风险。

4. 使用更简单或更合适的模型:选择一个更简单或更合适的模型,以减少模型的复杂度,从而降低过学习的风险。

5. 数据增强(Data augmentation):通过增加训练数据的数量和多样性,来提高模型的泛化能力。这可以通过旋转、缩放、翻转等操作来实现。

6. 早停(Early stopping):在训练过程中,当验证集上的性能不再提高时,停止训练。这可以防止模型过度拟合训练数据。

7. dropout:在训练过程中,随机丢弃一部分神经元,以减少模型对特定训练数据的依赖,从而提高模型的泛化能力。

通过采用这些策略,可以有效地防止过学习,提高模型的泛化能力和实际应用效果。

什么是过学习?

过学习(Overfitting)是机器学习中常见的一个问题,指的是模型在训练数据上表现良好,但在未见过的测试数据上表现不佳。简单来说,过学习就是模型对训练数据“过度拟合”,以至于它学会了数据中的噪声和随机波动,而不是真正的数据规律。

过学习的原因

过学习通常由以下几个原因引起:

模型复杂度过高:当模型过于复杂时,它可能会捕捉到训练数据中的噪声,而不是真正的数据特征。

训练数据量不足:如果训练数据量不足以覆盖所有可能的特征和模式,模型可能会在训练数据上过拟合。

数据分布不均匀:如果训练数据中某些类别或特征的样本数量远多于其他类别或特征,模型可能会偏向于多数类别,导致过学习。

过学习的表现

过学习在模型表现上通常有以下几种特征:

训练误差低,测试误差高:模型在训练数据上表现良好,但在测试数据上表现不佳。

模型泛化能力差:模型无法推广到新的数据集。

模型对噪声敏感:模型对训练数据中的噪声和随机波动过于敏感。

如何避免过学习

为了避免过学习,可以采取以下几种方法:

简化模型:降低模型的复杂度,例如减少模型的参数数量或使用正则化技术。

增加训练数据:收集更多的训练数据,以覆盖更多的特征和模式。

数据增强:通过数据增强技术,如旋转、缩放、裁剪等,增加训练数据的多样性。

交叉验证:使用交叉验证技术,如k折交叉验证,来评估模型的泛化能力。

正则化:在模型训练过程中添加正则化项,如L1或L2正则化,以惩罚模型复杂度。

过学习的实际案例

房价预测:一个复杂的模型可能能够准确地预测训练数据中的房价,但在新的数据集上预测效果不佳。

图像识别:一个过拟合的图像识别模型可能能够准确地识别训练数据中的图像,但在新的图像上识别效果不佳。

文本分类:一个过拟合的文本分类模型可能能够准确地分类训练数据中的文本,但在新的文本上分类效果不佳。

过学习是机器学习中一个常见且重要的问题。了解过学习的原因、表现和避免方法,对于提高模型性能和泛化能力至关重要。通过采取适当的措施,如简化模型、增加训练数据、数据增强和正则化等,可以有效避免过学习,提高模型的泛化能力。

- 过学习

- 机器学习

- 模型复杂度

- 训练数据

- 正则化

- 数据增强

- 泛化能力