1. 目标检测: 在树莓派上轻松实现深度学习目标检测:这篇文章介绍了如何使用树莓派进行目标检测,适用于识别汽车、橘子、签名等物体。详细信息和代码可以在 查看。

2. 硬件选择: 用树莓派4B构建深度学习应用(一)硬件篇:这篇文章详细介绍了如何选择适合深度学习的树莓派硬件,包括树莓派4B(4GB或8GB版本)的推荐,以及构建AI应用所需的硬件设备。更多信息请参考 。

3. 深度学习框架: 从零开始用树莓派4B玩深度学习:介绍了在树莓派上运行深度学习项目的技巧和解决常见问题的方法,包括使用proxychains加快pip源的速度和使用opencv调用darknet的方法。详细内容请查看 。 在树莓派5上使用pytroch进行模型训练:记录了在树莓派5上运行pytroch训练代码的全过程,包括新建虚拟环境、安装pytorch、配置Tonny IDE、运行训练代码等。详细内容请查看 。

4. 实际项目: 在树莓派4B上部署自己训练的yolov5模型:详细记录了在树莓派4B上部署YOLOv5模型的过程,包括模型训练、模型转换和推理步骤。更多信息请参考 。

5. 环境搭建: 树莓派入门:Python机器学习实战:介绍了如何通过Python在树莓派上实现机器学习项目,开启智能硬件新篇章。详细内容请查看 。

6. 实时推理: 树莓派 4 上的实时推理 :指导如何在树莓派 4 上设置 PyTorch 并实时运行 MobileNet v2 分类模型。详细内容请参考 。

这些资源和教程可以帮助你在树莓派上成功进行机器学习项目。如果你有具体的项目需求或问题,可以参考上述资源进行进一步的学习和实践。

树莓派:机器学习的理想平台

树莓派的硬件优势

树莓派拥有强大的硬件配置,包括四核ARM处理器、1GB内存以及丰富的接口。这使得树莓派在处理机器学习任务时,能够提供足够的计算能力,同时保持低功耗。

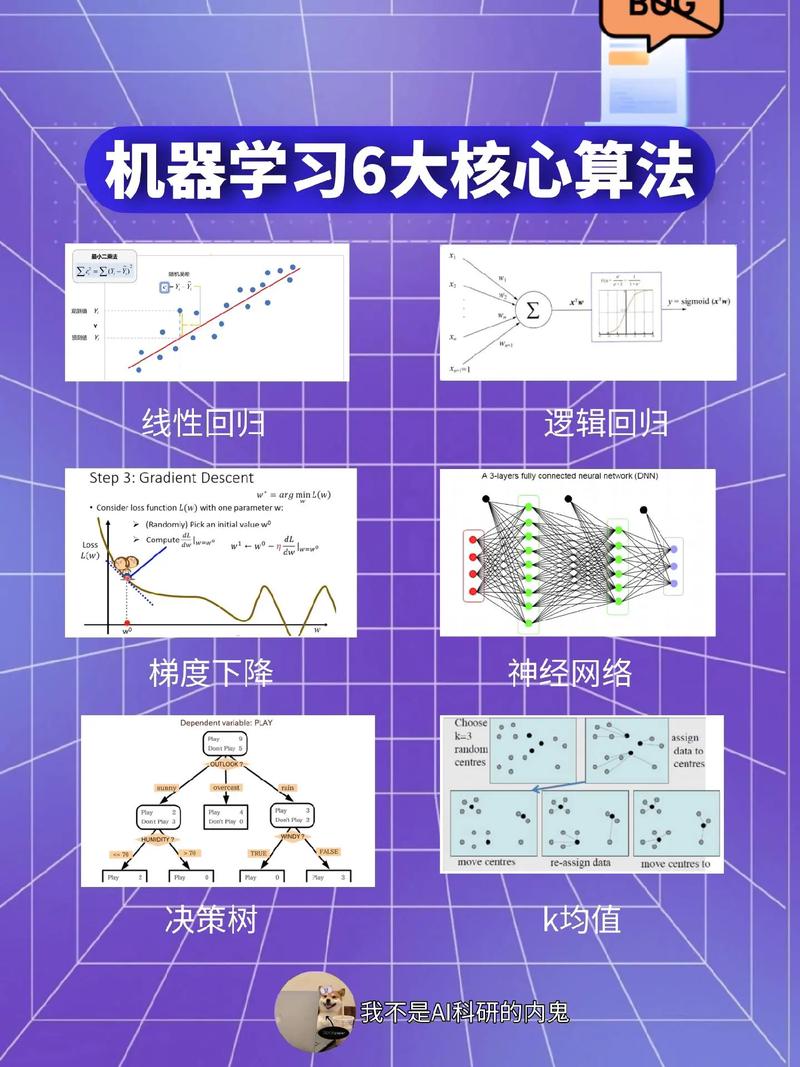

树莓派上运行的机器学习框架

在树莓派上,我们可以使用多种机器学习框架进行开发,如TensorFlow、PyTorch、Keras等。这些框架提供了丰富的算法和工具,方便开发者进行机器学习项目的开发。

TensorFlow在树莓派上的应用

TensorFlow是Google开发的一款开源机器学习框架,广泛应用于图像识别、自然语言处理等领域。在树莓派上,我们可以使用TensorFlow进行图像识别、语音识别等项目的开发。

示例:使用TensorFlow在树莓派上进行图像识别

以下是一个简单的示例,展示如何在树莓派上使用TensorFlow进行图像识别:

```python

import tensorflow as tf

from tensorflow.keras.layers import Dense, Conv2D, Flatten, MaxPooling2D

创建模型

Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)),

MaxPooling2D(2, 2),

Flatten(),

Dense(64, activation='relu'),

Dense(10, activation='softmax')

编译模型

加载数据集

(x_train, y_train), (x_test, y_test) = tf.keras.datasets.cifar10.load_data()

训练模型

评估模型

print('\

Test accuracy:', test_acc)

PyTorch在树莓派上的应用

PyTorch是Facebook开发的一款开源机器学习框架,以其简洁的API和动态计算图而受到广泛关注。在树莓派上,我们可以使用PyTorch进行图像识别、自然语言处理等项目的开发。

示例:使用PyTorch在树莓派上进行图像识别

以下是一个简单的示例,展示如何在树莓派上使用PyTorch进行图像识别:

```python

import torch

import torchvision

import torchvision.transforms as transforms

from torch.utils.data import DataLoader

from torch import nn, optim

创建模型

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(3, 6, 5)

self.pool = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(6, 16, 5)

self.fc1 = nn.Linear(16 5 5, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = x.view(-1, 16 5 5)

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

net = Net()

编译模型

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(net.parameters(), lr=0.001, momentum=0.9)

加载数据集

transform = transforms.Compose([transforms.ToTensor()])

trainset = torchvision.datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

trainloader = DataLoader(trainset, batch_size=4, shuffle=True)

训练模型

for epoch in range(2): loop over the dataset multiple times

running_loss = 0.0

for i, data in enumerate(trainloader, 0):

inputs, labels = data

optimizer.zero_grad()

outputs = net(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss = loss.item()

if i % 2000 == 1999: print every