在Linux中,你可以使用几种不同的命令来去重文件中的内容。下面是几个常用的命令:

1. `sort` 和 `uniq` 命令组合: `sort` 命令用于排序文件中的行。 `uniq` 命令用于报告或忽略重复的行。 组合使用这两个命令,可以有效地去重。

示例: ```bash sort file.txt | uniq > output.txt ``` 这条命令首先对 `file.txt` 进行排序,然后使用 `uniq` 去除重复的行,并将结果保存到 `output.txt`。

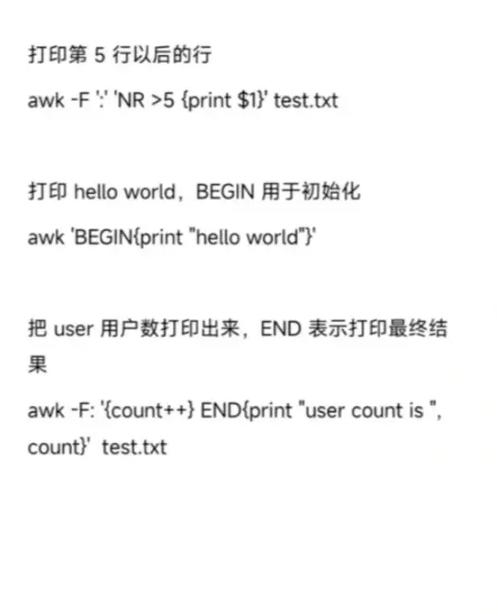

2. `awk` 命令: `awk` 是一个强大的文本处理工具,可以用于去重。

示例: ```bash awk '!seen ' file.txt > output.txt ``` 这条命令使用 `awk` 的数组 `seen` 来跟踪已经见过的行,如果行已经存在,则不会输出。

3. `grep` 命令: `grep` 通常用于搜索文件中的特定模式,但也可以用于去重。

示例: ```bash grep xv f file.txt file.txt > output.txt ``` 这条命令使用 `grep` 的 `x` 选项(匹配整行)和 `v` 选项(反转匹配),从 `file.txt` 中移除重复的行,并将结果保存到 `output.txt`。

4. `sed` 命令: `sed` 是一个流编辑器,也可以用于去重。

示例: ```bash sed i '/./{H;$!d};x;//!{g;s/.//};' file.txt > output.txt ``` 这条命令使用 `sed` 的循环和替换功能来去重。

5. `awk` 去重命令的另一个示例: ```bash awk '{a } END {for if == 1qwe2 print i}' file.txt > output.txt ``` 这条命令使用 `awk` 的数组 `a` 来存储每行的计数,然后只输出那些计数为1的行。

请根据你的具体需求选择合适的命令。如果你有特定的需求或问题,请告诉我,我可以提供更详细的帮助。

Linux系统中的去重命令详解

在Linux系统中,数据去重是一个常见且重要的操作。去重可以帮助我们清理重复的数据,提高数据处理的效率。本文将详细介绍Linux系统中常用的去重命令及其使用方法。

uniq命令——去除相邻重复行

uniq命令是Linux系统中用于去除已排序文件中相邻重复行的命令。它通常与sort命令结合使用,以确保文件内容已正确排序。

使用方法:

shell sort file.txt uniq > newfile.txt

这条命令会将file.txt文件排序后去除其中的重复行,并将结果保存到newfile.txt文件中。

sort命令——对文件内容进行排序

sort命令可以对文件的内容进行排序。结合重定向功能,我们可以使用sort命令去除文件中的重复行。

使用方法:

shell sort -u file.txt > newfile.txt

这条命令会将file.txt文件中的重复行去除,并将结果保存到newfile.txt文件中。

awk命令——强大的文本处理工具

awk命令是一个强大的文本处理工具,可以用于去除文件中的重复行。它通过内置的变量和表达式来处理文本数据。

使用方法:

shell awk '!seen[0]' file.txt > newfile.txt

这条命令会去除file.txt文件中的重复行,并将结果保存到newfile.txt文件中。

comm命令——比较两个已排序的文件

comm命令可以用于比较两个已排序的文件,并输出它们的交集、差集等信息。通过使用comm命令的某些选项,可以实现对文件中的重复行进行去除。

使用方法:

shell comm -12 newfile.txt

这条命令会将file1.txt和file2.txt两个文件中的重复行去除,并将结果保存到newfile.txt文件中。

如果您还有其他关于Linux去重命令的问题,欢迎在评论区留言讨论。