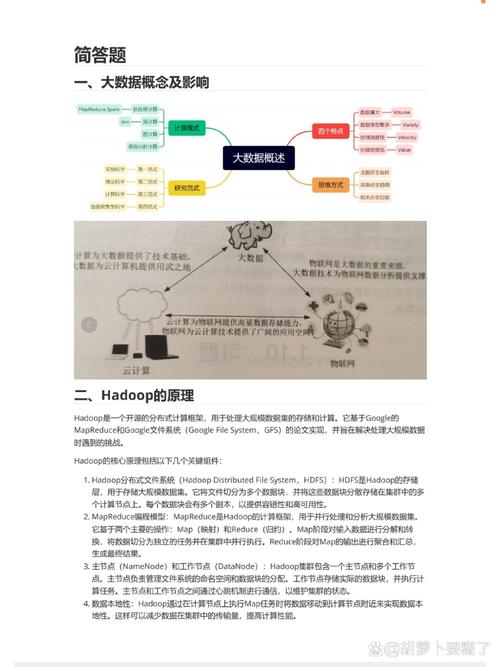

1. Hadoop:Hadoop是一个开源的分布式计算框架,它允许用户在低成本的硬件上处理大规模数据集。Hadoop的核心组件包括HDFS(Hadoop Distributed File System)和MapReduce。

2. Spark:Apache Spark是一个快速、通用的大数据处理引擎,它提供了多种数据抽象,包括RDD(Resilient Distributed Dataset)、DataFrame和Dataset。Spark支持批处理、流处理、机器学习和图处理。

3. Flink:Apache Flink是一个流处理框架,它支持事件驱动的应用和实时分析。Flink提供了高效的数据处理能力,并且可以与Hadoop、Spark等框架集成。

4. Kafka:Apache Kafka是一个分布式流处理平台,它用于构建实时数据管道和流应用程序。Kafka可以处理高吞吐量的数据流,并且提供了可扩展性和容错性。

5. Hive:Hive是一个基于Hadoop的数据仓库工具,它提供了SQL接口,允许用户对存储在HDFS上的数据进行查询。Hive适合于数据分析和报告。

6. Pig:Pig是一个基于Hadoop的高层脚本语言,它允许用户以类似SQL的方式处理大规模数据集。Pig提供了丰富的数据处理函数和操作符。

7. Druid:Druid是一个实时分析数据存储,它专为快速查询而设计。Druid支持实时数据摄取、快速查询和灵活的数据模型。

8. Elasticsearch:Elasticsearch是一个基于Lucene的搜索引擎,它提供了实时搜索和分析能力。Elasticsearch常用于日志分析、搜索应用和监控。

9. TensorFlow:TensorFlow是一个开源的机器学习框架,它用于构建和训练机器学习模型。TensorFlow支持多种编程语言,并且可以与Hadoop、Spark等框架集成。

10. Dask:Dask是一个并行计算库,它允许用户在单台机器或集群上处理大规模数据集。Dask支持Numpy、Pandas和ScikitLearn等库。

11. Ray:Ray是一个分布式计算框架,它提供了高性能的并行和分布式计算能力。Ray支持Python编程语言,并且可以与TensorFlow、PyTorch等机器学习框架集成。

12. Kubernetes:Kubernetes是一个开源的容器编排系统,它用于自动化部署、扩展和管理容器化应用程序。Kubernetes可以与各种大数据框架集成,以实现高效的数据处理和存储。

这些大数据技术框架可以根据具体的应用需求进行选择和组合,以构建高效、可扩展的大数据解决方案。

大数据技术框架概述

大数据技术框架的构成

大数据技术框架主要包括以下几个部分:

数据采集:通过各种手段收集数据,如日志、传感器、网络爬虫等。

数据存储:将采集到的数据进行存储,常用的存储技术有HDFS、HBase、Cassandra等。

数据处理:对存储的数据进行清洗、转换、聚合等操作,常用的处理技术有MapReduce、Spark、Flink等。

数据挖掘:从处理后的数据中提取有价值的信息,常用的挖掘技术有机器学习、数据挖掘算法等。

数据可视化:将数据以图表、图形等形式展示出来,便于用户理解和分析,常用的可视化工具有Tableau、ECharts等。

大数据技术框架的特点

大数据技术框架具有以下特点:

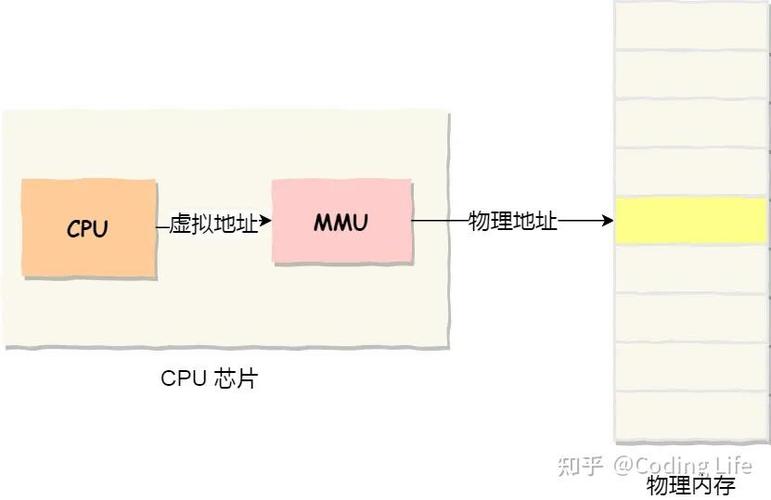

分布式存储和计算:能够处理海量数据,提高数据处理效率。

高可用性:在硬件故障、网络故障等情况下,系统仍能正常运行。

可扩展性:能够根据需求进行水平扩展,提高系统性能。

跨平台性:支持多种编程语言和操作系统,便于集成和应用。

常用的大数据技术框架

Hadoop:由Apache基金会开发,包括HDFS、MapReduce、YARN等组件,主要用于处理大规模数据集。

Spark:由Apache基金会开发,支持内存计算和多种数据源,适用于实时处理和分析。

Flink:由Apache基金会开发,适用于实时数据处理,具有高吞吐量和低延迟的特点。

Storm:由Twitter公司开发,适用于实时数据处理,具有高可靠性和可扩展性。

Fitting:由大快搜索主导的完全开源项目,旨在为大数据领域提供统一的开发框架。

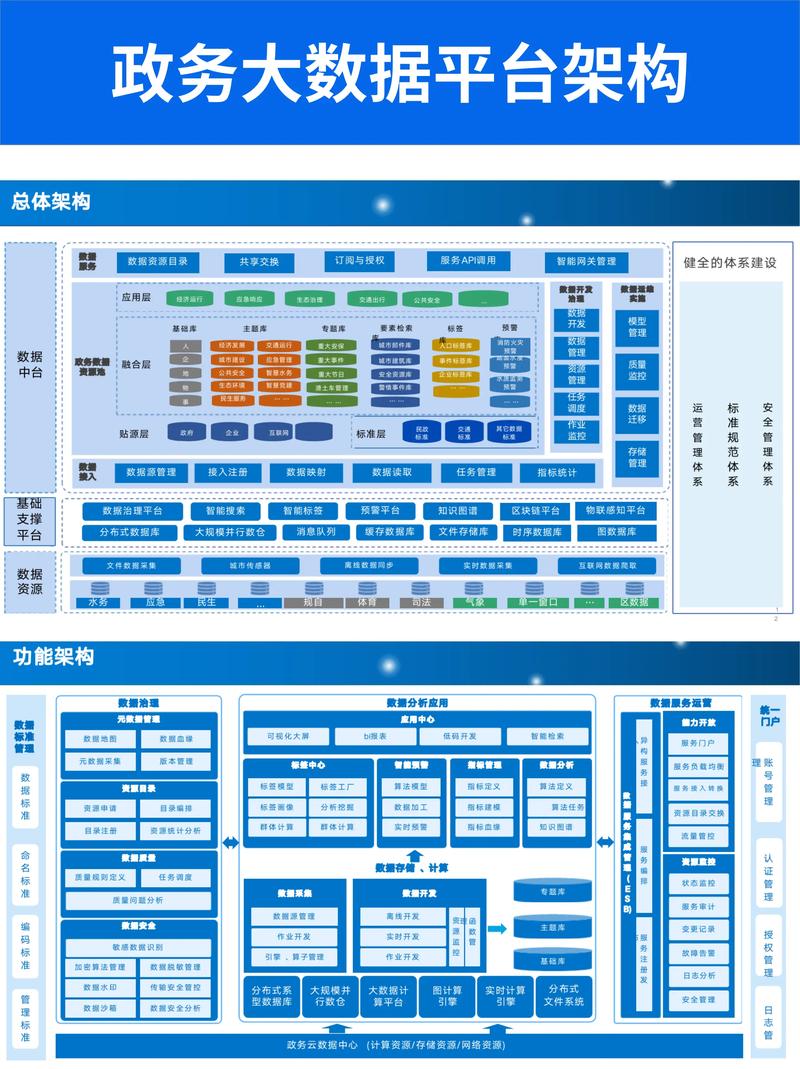

大数据技术框架的应用场景

金融行业:用于风险控制、欺诈检测、客户画像等。

医疗行业:用于疾病预测、患者管理、药物研发等。

零售行业:用于客户行为分析、精准营销、供应链优化等。

政府行业:用于公共安全、城市规划、政策制定等。

教育行业:用于学生成绩分析、教育资源配置、个性化推荐等。

大数据技术框架是处理海量数据的核心工具,对于企业来说至关重要。随着大数据技术的不断发展,大数据技术框架将更加成熟和完善,为各行各业带来更多价值。