大数据环境搭建是一个涉及多个组件和技术的复杂过程,通常包括以下几个步骤:

1. 需求分析:明确大数据环境搭建的目的,确定需要处理的数据类型、规模和性能要求。

2. 硬件选择:根据需求选择合适的硬件设备,包括服务器、存储设备、网络设备等。

3. 软件选择:选择适合的大数据软件平台,如Hadoop、Spark、Flink等,以及相关的大数据工具和库。

4. 系统设计:设计大数据系统的架构,包括数据采集、存储、处理、分析和展示等模块。

5. 环境搭建:安装和配置大数据软件平台及相关工具,搭建大数据环境。

6. 数据准备:收集和准备需要处理的数据,确保数据的完整性和准确性。

7. 数据处理:使用大数据平台对数据进行处理,包括数据清洗、数据转换、数据挖掘等。

8. 数据分析:对处理后的数据进行分析,提取有价值的信息和洞察。

9. 结果展示:将分析结果以图表、报告等形式展示出来,供决策者参考。

10. 系统优化:根据实际运行情况,对大数据系统进行优化和调整,提高系统的性能和稳定性。

11. 安全保障:加强大数据系统的安全保障,包括数据加密、访问控制、备份恢复等。

12. 运维管理:建立完善的运维管理制度,确保大数据系统的稳定运行。

13. 人员培训:对相关人员进行大数据技术和应用的培训,提高他们的技能水平。

14. 持续改进:根据业务发展和技术进步,不断优化和改进大数据环境。

大数据环境搭建是一个持续的过程,需要不断地调整和优化,以适应不断变化的需求和技术发展。

大数据环境搭建全攻略:从基础到实战

随着大数据时代的到来,越来越多的企业和组织开始关注大数据技术的应用。大数据环境搭建是大数据应用的第一步,也是关键的一步。本文将为您详细介绍大数据环境搭建的整个过程,从基础准备到实战应用,助您轻松入门大数据领域。

一、大数据环境搭建概述

大数据环境搭建主要包括以下几个步骤:

硬件选择与配置

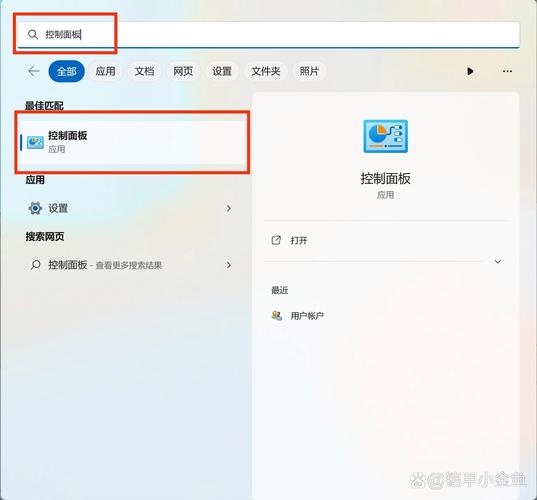

操作系统安装与配置

大数据软件安装与配置

集群搭建与优化

数据导入与处理

二、硬件选择与配置

服务器:选择性能稳定、扩展性好的服务器,如Intel Xeon系列处理器。

内存:根据数据量大小,建议配置64GB以上内存。

硬盘:选择高速、大容量的硬盘,如SSD或RAID磁盘阵列。

网络:确保网络带宽充足,支持高速数据传输。

三、操作系统安装与配置

CentOS

Ubuntu

Debian

安装完成后,进行以下配置:

设置静态IP地址

关闭防火墙

优化系统参数

四、大数据软件安装与配置

大数据环境搭建需要安装以下软件:

Hadoop:分布式文件系统(HDFS)和分布式计算框架(MapReduce)。

Spark:快速、通用的大数据处理引擎。

Hive:基于Hadoop的数据仓库工具。

Flume:数据采集工具。

Kafka:分布式流处理平台。

以下以Hadoop为例,介绍安装与配置过程:

下载Hadoop安装包。

解压安装包到指定目录。

配置环境变量。

配置Hadoop配置文件。

启动Hadoop服务。

五、集群搭建与优化

单节点集群:适用于小型项目或测试环境。

多节点集群:适用于大型项目或生产环境。

集群优化:调整Hadoop配置文件,优化资源分配、数据存储和计算效率。

六、数据导入与处理

数据采集:使用Flume、Kafka等工具采集数据。

数据存储:使用HDFS、HBase等存储数据。

数据处理:使用MapReduce、Spark等处理数据。

数据挖掘:使用Hive、Pig等工具进行数据挖掘。

大数据环境搭建是大数据应用的基础,掌握大数据环境搭建技术对于从事大数据相关工作至关重要。本文从硬件选择、操作系统配置、大数据软件安装、集群搭建、数据导入与处理等方面,为您详细介绍了大数据环境搭建的全过程。希望本文能帮助您顺利入门大数据领域。