大数据处理的一般过程

随着信息技术的飞速发展,大数据已经成为各行各业关注的焦点。大数据处理是指对海量数据进行采集、存储、管理、分析和挖掘的过程。本文将详细介绍大数据处理的一般过程,帮助读者更好地理解这一复杂而重要的技术。

一、数据采集

数据采集是大数据处理的第一步,也是最为关键的一步。数据采集的主要任务是从各种数据源中获取原始数据,包括结构化数据、半结构化数据和非结构化数据。

结构化数据:如关系型数据库中的表格数据。

半结构化数据:如XML、JSON等格式数据。

非结构化数据:如图像、音频、视频等。

数据采集的方法包括:

直接访问数据源:如数据库、文件系统等。

网络爬虫:从互联网上抓取数据。

传感器数据采集:从物联网设备中获取数据。

二、数据存储

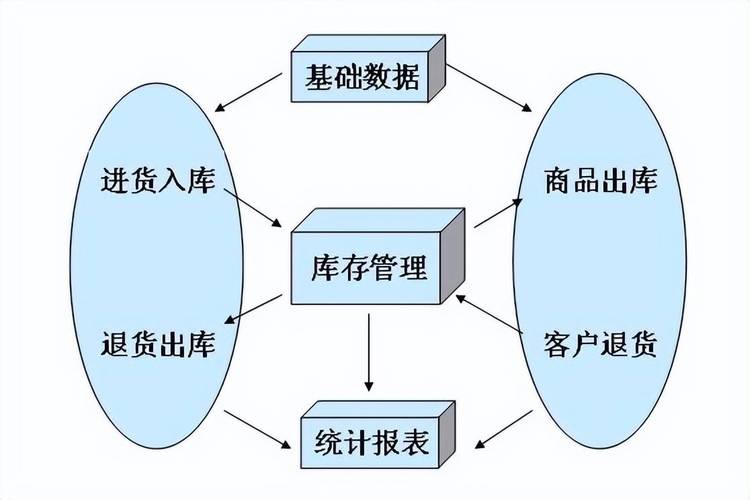

数据存储是大数据处理的基础,其目的是将采集到的数据存储在合适的存储系统中,以便后续的数据处理和分析。

关系型数据库:如MySQL、Oracle等。

分布式数据库:如HBase、Cassandra等。

分布式文件系统:如HDFS、Ceph等。

数据仓库:如Oracle Exadata、Teradata等。

数据存储的关键技术包括:

数据压缩:减少存储空间占用。

数据加密:保障数据安全。

数据备份:防止数据丢失。

三、数据预处理

数据预处理是大数据处理的重要环节,其目的是提高数据质量,为后续的数据分析提供可靠的数据基础。

数据清洗:去除重复数据、错误数据、缺失数据等。

数据转换:将数据转换为统一的格式。

数据集成:将来自不同数据源的数据整合在一起。

数据预处理的方法包括:

ETL(Extract-Transform-Load):提取、转换、加载。

数据清洗工具:如Pandas、Spark SQL等。

四、数据分析

数据分析是大数据处理的核心环节,其目的是从海量数据中提取有价值的信息,为决策提供支持。

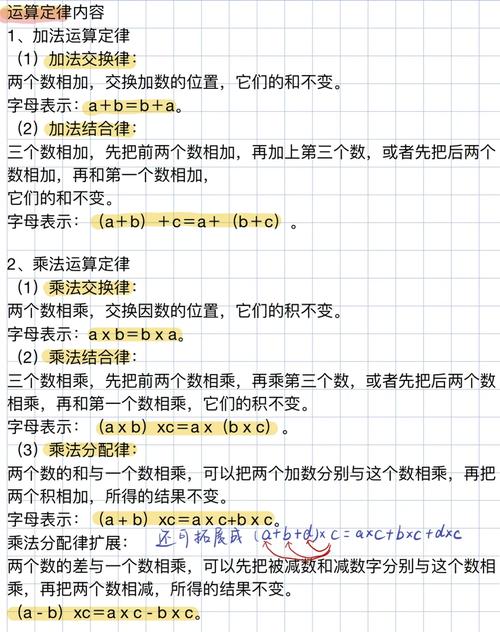

统计分析:如描述性统计、推断性统计等。

数据挖掘:如聚类、分类、关联规则挖掘等。

机器学习:如决策树、支持向量机、神经网络等。

数据分析的方法包括:

SQL查询:如MySQL、Oracle等。

数据挖掘工具:如R、Python等。

机器学习平台:如TensorFlow、PyTorch等。

五、数据可视化

数据可视化是将数据分析结果以图形、图像等形式展示出来,使数据更加直观易懂。

图表:如柱状图、折线图、饼图等。

地图:如地理信息系统(GIS)。

交互式可视化:如D3.js、Highcharts等。

数据可视化的工具包括:

图表库:如ECharts、Highcharts等。

GIS平台:如ArcGIS、QGIS等。

大数据处理是一个复杂而系统的过程,涉及数据采集、存储、预处理、分析、可视化和应用等多个环节。掌握大数据处理的一般