1. 面试准备 1.1 技术栈准备 Hadoop生态圈:包括HDFS、MapReduce、YARN、Hive、HBase等。需要详细了解这些组件的工作原理、优缺点和实际应用场n 知乎:有丰富的面试经验和面试题分享,可以帮助你了解不同公司的面试流程和考察点。 CSDN:详细的大数据面试笔记,包括HDFS、MapReduce、YARN、Zookeeper、Kafka、HBase、Hive、Spark等技术的面试重点。

大数据面试准备的重要性

在当今数据驱动的时代,大数据技术人才的需求日益增长。对于求职者来说,通过大数据面试不仅是对个人技能的检验,更是对职业发展的一次重要机会。因此,充分的面试准备显得尤为重要。

了解大数据基础知识

Hadoop生态系统:包括HDFS、MapReduce、YARN等组件及其作用。

Spark:了解Spark的架构、核心组件(如Spark SQL、Spark Streaming)以及与Hadoop的对比。

数据仓库:熟悉星型模型、雪花模型、维度建模等概念。

数据清洗与处理:了解数据清洗的流程、常用工具和算法。

数据库知识:掌握SQL语言,了解关系型数据库和非关系型数据库的基本原理。

实战经验与项目案例

参与项目:在项目中积累经验,了解大数据技术的实际应用。

开源贡献:参与开源项目,提升代码编写和解决问题的能力。

模拟面试:通过模拟面试,提前适应面试场景,提高应对能力。

常见面试题解析

问题:HDFS的写入流程是怎样的?

解析:数据写入HDFS时,首先通过客户端上传数据到NameNode,然后NameNode将数据分配到DataNode上,并存储在HDFS的块中。写入过程中,HDFS会进行数据校验和副本复制,确保数据可靠性。

问题:Spark的shuffle过程是怎样的?

解析:在Spark中,shuffle过程是指将数据从Map阶段传输到Reduce阶段的过程。shuffle过程中,Spark会根据key对数据进行分组,并将相同key的数据发送到同一个Reducer上,从而实现数据的聚合。

问题:如何优化Spark作业的性能?

解析:优化Spark作业性能可以从多个方面入手,如合理设置并行度、选择合适的shuffle策略、优化数据分区等。

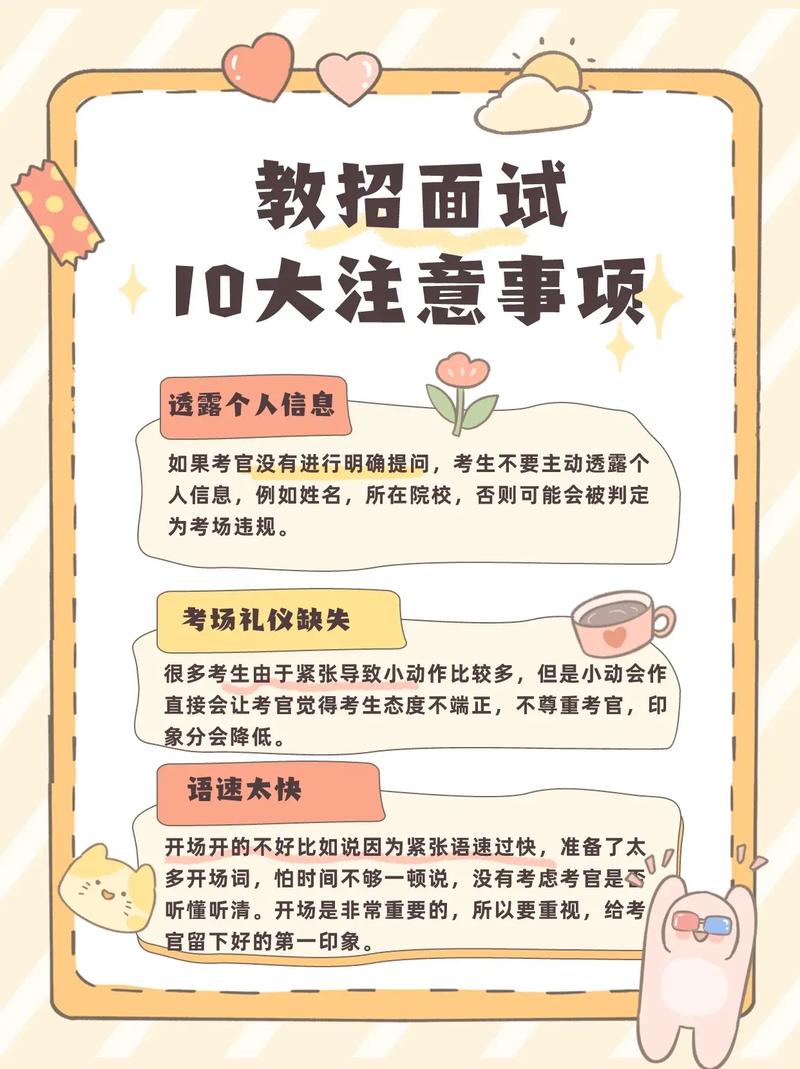

面试技巧与注意事项

在面试过程中,以下技巧和注意事项有助于求职者取得好成绩:

自信:保持自信,清晰地表达自己的观点。

逻辑清晰:回答问题时,注意逻辑清晰,条理分明。

展示热情:对大数据技术充满热情,让面试官感受到你的兴趣。

提问环节:在面试结束时,可以提出一些问题,展示自己的求知欲。

着装得体:面试时,着装得体,给面试官留下良好的第一印象。

大数据面试是一个全面考察求职者技能和素质的过程。通过充分的准备,掌握核心知识点,积累实战经验,并运用面试技巧,相信求职者一定能够在面试中脱颖而出,成功获得心仪的职位。