1. 分布式处理框架:如Hadoop、Spark等,它们可以将数据分布到多个节点上进行处理,提高处理速度和可靠性。

2. 数据库和数据仓库:如Hive、HBase、Cassandra等,它们可以存储和管理大规模的数据集,并提供高效的查询和数据处理能力。

3. 数据集成工具:如Talend、Informatica等,它们可以提供图形化的界面和自动化工具,简化ETL过程。

4. 数据清洗和转换工具:如Pentaho Data Integration、Trifacta等,它们可以帮助用户对数据进行清洗、转换和规范化处理。

5. 数据质量控制工具:如DataGrip、Talend Data Quality等,它们可以帮助用户对数据进行质量控制,确保数据质量和准确性。

6. 数据安全和隐私保护工具:如Apache Ranger、Cloudera Navigator等,它们可以帮助用户对数据进行安全控制和隐私保护。

7. 云计算平台:如AWS、Azure、Google Cloud等,它们提供了丰富的云服务和资源,可以帮助用户快速搭建和扩展大数据处理平台。

在处理大数据ETL时,需要根据具体的数据规模、处理需求和业务场景选择合适的工具和方法。同时,还需要考虑数据的安全、隐私、质量和可靠性等方面的问题,确保数据处理的合规性和有效性。

深入解析大数据ETL:流程、工具与最佳实践

随着大数据时代的到来,企业对数据的处理和分析需求日益增长。ETL(Extract, Transform, Load)作为数据仓库和数据湖构建的核心环节,其重要性不言而喻。本文将深入解析大数据ETL的流程、常用工具以及最佳实践,帮助读者全面了解这一关键技术。

ETL是数据仓库领域的重要概念,它代表数据从源系统到目标系统的三个主要步骤:抽取(Extract)、转换(Transform)和加载(Load)。

抽取:从各种数据源(如数据库、日志文件、API等)中提取数据。

转换:对抽取的数据进行清洗、格式转换、合并、拆分等操作,使其符合目标系统的要求。

加载:将转换后的数据加载到目标系统(如数据仓库、数据湖等)中。

FineDatalink:帆软旗下的一款ETL工具,具备高效的数据集成能力、灵活的数据转换功能以及出色的数据清洗能力。

Apache Nifi:一个强大的数据流管理工具,提供用户友好的界面,支持广泛的数据源和目标系统。

Apache Spark:一个快速的统一分析引擎,适用于大规模数据处理,支持批处理、实时数据流处理和机器学习任务。

Talend:一个开源的ETL工具,提供丰富的数据处理功能,支持多种数据源和目标系统。

Informatica:一个商业化的ETL工具,具备强大的数据处理能力和丰富的功能。

Microsoft SQL Server Integration Services(SSIS):微软提供的一款ETL工具,适用于Windows平台,支持多种数据源和目标系统。

以下是大数据ETL流程的步骤以及一些最佳实践:

数据需求分析:根据业务需求,确定需要提取、转换和加载的数据,分析其结构和特征。

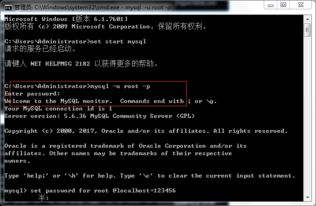

数据源准备:选择适当的数据源,并进行连接、授权等相关设置,以保证能够提取所需的数据。

数据提取:使用相应的ETL工具,从数据源中提取所需数据,并将其暂存到缓冲区中。

数据清洗和转换:对提取的数据进行清洗和转换,包括数据格式转换、去除重复记录、填补缺失值、数据标准化等。

数据加载:将清洗和转换后的数据加载到目标系统(如数据仓库、数据湖等)中,保证数据的完整性和一致性。

错误处理和监控:在数据处理过程中,监控和处理可能出现的错误,如数据源连接失败、错误数据处理等,保证数据流的稳定和正确。

数据验证和测试:对加载到目标数据仓库或数据湖中的数据进行验证和测试,确保数据的准确性和完整性。

调度和自动化:设置自动化调度,定期执行ETL流程,确保数据的及时更新和同步。

日志记录和性能优化:记录ETL流程的日志,并进行性能优化,如调整数据提取的并发数、增加缓存大小等,以提高ETL过程的效率和稳定性。

大数据ETL作为数据仓库和数据湖构建的核心环节,对于企业数据分析和决策具有重要意义。通过深入了解ETL的流程、常用工具以及最佳实践,企业可以更好地利用数据,提升业务竞争力。