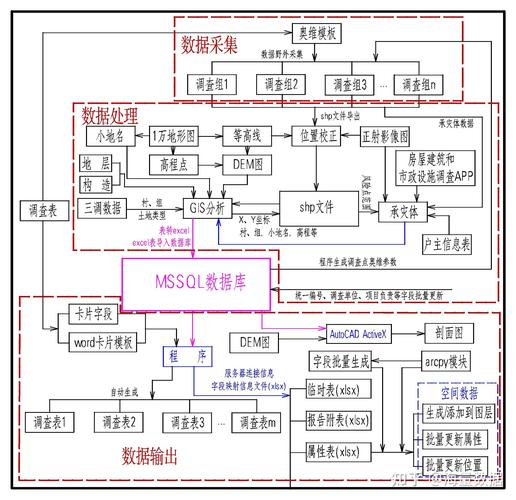

大数据的基本处理流程可以分为以下几个步骤:

1. 数据采集:首先需要从各种来源收集数据,这些来源可能包括社交网络、物联网设备、企业数据库等。数据采集可以使用多种技术,如API、爬虫、日志收集等。

2. 数据预处理:收集到的数据往往是不完整、不一致或错误的,因此需要进行数据清洗和转换。这包括去除重复数据、填补缺失值、纠正错误数据、数据格式转换等。

3. 数据存储:处理后的数据需要存储在合适的存储系统中,以便于后续的分析和处理。常见的存储系统包括关系型数据库、NoSQL数据库、数据湖等。

4. 数据分析:对存储的数据进行分析,以发现其中的模式和趋势。数据分析可以使用多种技术,如统计分析、机器学习、数据挖掘等。

5. 数据可视化:将分析结果以图表、报告等形式呈现出来,以便于用户理解和决策。数据可视化可以使用多种工具,如Tableau、Power BI、Python的Matplotlib等。

6. 数据应用:根据分析结果,制定相应的业务策略或优化方案,以实现业务目标。数据应用可能涉及多个领域,如市场营销、产品开发、风险管理等。

7. 数据安全与隐私保护:在处理大数据的过程中,需要确保数据的安全性和隐私性。这包括数据加密、访问控制、审计跟踪等。

8. 数据生命周期管理:随着数据的不断增长,需要定期对数据进行备份、归档和删除,以保持数据的有效性和可用性。

以上是大数据的基本处理流程,不同的应用场景可能需要调整或优化这些步骤。

大数据处理流程概述

随着信息技术的飞速发展,大数据已经成为当今社会的重要资源。大数据处理流程是挖掘数据价值的关键步骤,它涉及数据的采集、存储、处理、分析和可视化等多个环节。本文将详细介绍大数据的基本处理流程,帮助读者更好地理解这一过程。

一、数据采集

数据采集是大数据处理流程的第一步,也是最为关键的一步。数据采集的主要目的是从各种数据源中获取原始数据,包括但不限于以下几种:

结构化数据:如数据库中的表格数据。

半结构化数据:如XML、JSON等格式数据。

非结构化数据:如图像、视频、音频、文本等。

数据采集的方法包括:

ETL(Extract, Transform, Load):从源系统中提取数据,进行转换,然后加载到目标系统中。

爬虫技术:从互联网上抓取数据。

API接口:通过应用程序编程接口获取数据。

二、数据存储

数据采集完成后,需要将数据存储在合适的存储系统中。大数据存储系统通常具有以下特点:

高可靠性:保证数据不丢失。

高扩展性:能够根据需求动态调整存储容量。

高性能:提供快速的数据访问和查询能力。

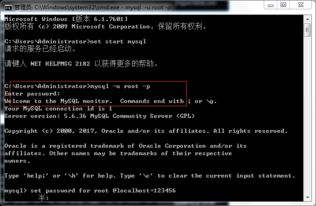

常见的大数据存储系统包括:

HDFS(Hadoop Distributed File System):Hadoop的分布式文件系统,适用于存储海量数据。

HBase:基于HDFS的分布式数据库,适用于存储非结构化数据。

Redis:高性能的键值存储系统,适用于缓存和实时数据处理。

三、数据处理

数据处理是对存储在数据库中的数据进行清洗、转换和整合的过程。数据处理的主要目的是提高数据质量,为后续的数据分析提供准确、可靠的数据基础。数据处理的主要步骤包括:

数据清洗:去除重复数据、缺失数据、异常数据等。

数据转换:将数据转换为统一的格式和结构。

数据整合:将来自不同数据源的数据进行整合,形成统一的数据视图。

常见的数据处理工具包括:

Spark:基于内存的分布式计算框架,适用于大规模数据处理。

MapReduce:Hadoop的分布式计算模型,适用于大规模数据处理。

ETL工具:如Informatica、Talend等,用于数据清洗、转换和加载。

四、数据分析

数据分析是对处理后的数据进行挖掘、分析和建模的过程,旨在从数据中提取有价值的信息和知识。数据分析的主要方法包括:

统计分析:对数据进行描述性统计、推断性统计和相关性分析等。

数据挖掘:从大量数据中挖掘出有价值的信息和模式。

机器学习:利用算法从数据中学习,预测未来的趋势和结果。

常见的数据分析工具包括:

Python:适用于数据分析和机器学习。

R语言:适用于统计分析。

SQL:适用于数据库查询和数据分析。

五、数据可视化

数据可视化是将数据分析的结果以图形、图像等形式展示出来的过程,有助于人们更好地理解数据背后的信息。数据可视化工具主要包括:

Tableau:适用于数据可视化和分析。

Power BI:适用于数据可视化和分析。

Matplotlib:Python的数据可视化库。

大数据处理流程是一个复杂而系统的过程,涉及多个环节和工具。通过了解大数据处理流程,我们可以更好地把握数据的价值,为企业和个人提供有针对性的解决方案。随着大数据技术的不断发展,大数据处理流程将更加高效、智能化,为各行各业带来更多机遇和挑战。