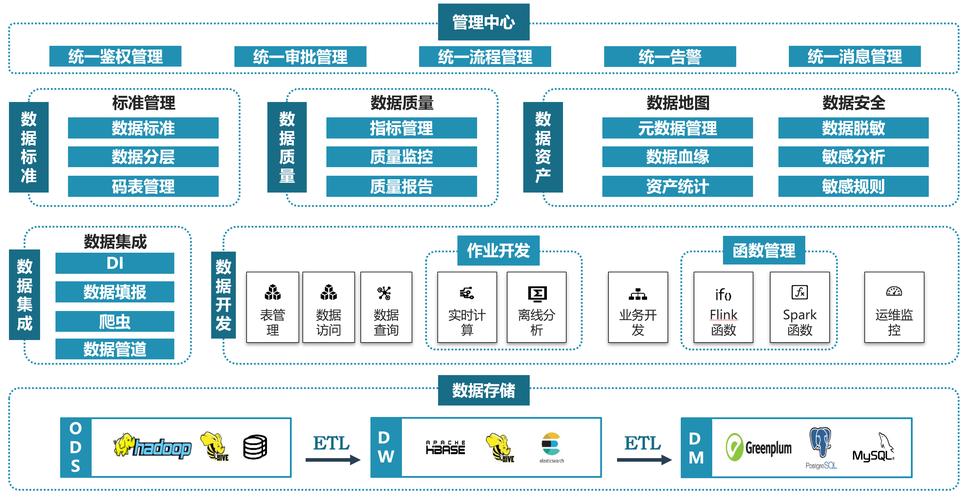

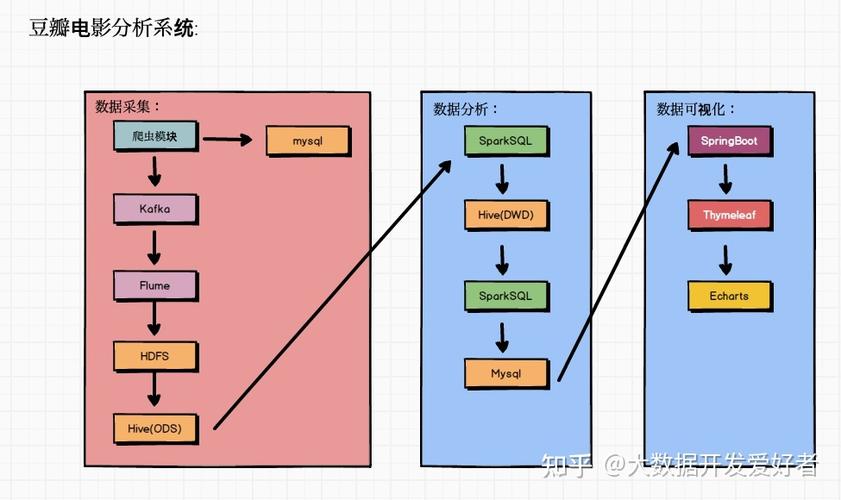

1. 数据收集与处理:学习如何收集、清洗和转换数据,以便进行后续分析。这包括使用工具如Hadoop、Spark、Kafka等。

2. 数据存储:了解不同的数据存储系统,如关系型数据库(如MySQL、PostgreSQL)、非关系型数据库(如MongoDB、Cassandra)、数据仓库(如Amazon Redshift、Google BigQuery)等。

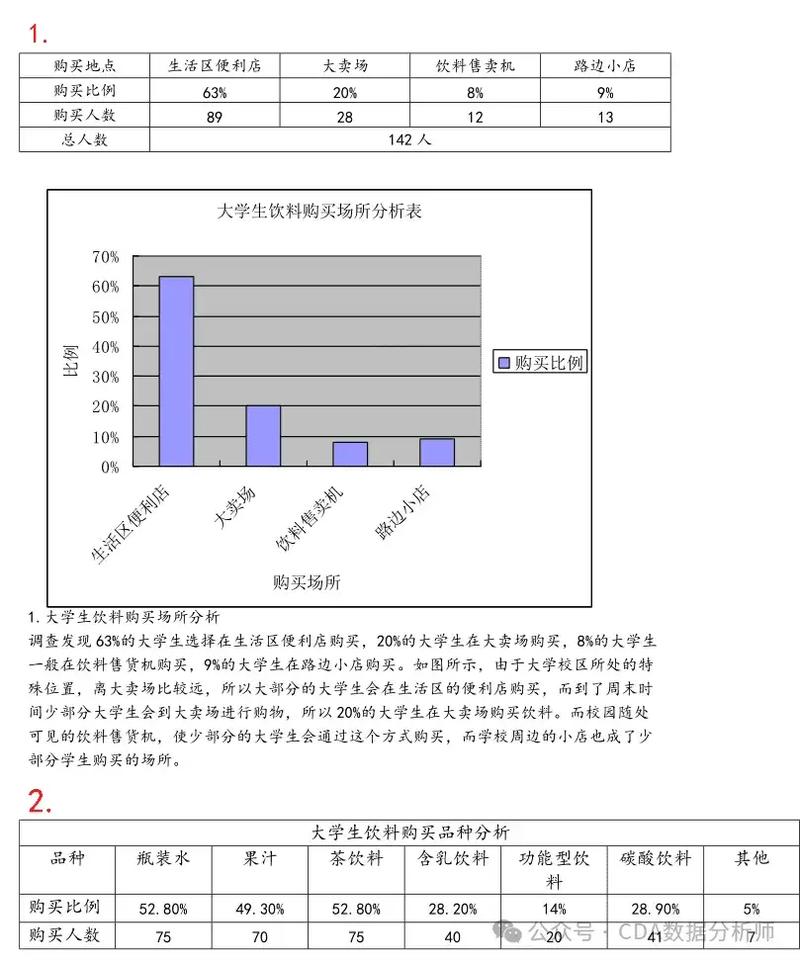

3. 数据分析:学习如何使用统计分析、数据挖掘和机器学习技术来分析和解释数据。这包括使用工具如R、Python、SQL等。

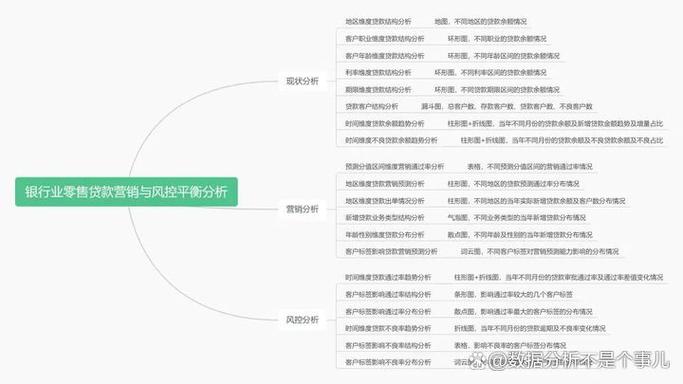

4. 数据可视化:学习如何将数据转换为图表和图形,以便更直观地理解和传达数据。这包括使用工具如Tableau、Power BI、D3.js等。

5. 大数据平台与工具:了解并学习使用各种大数据平台和工具,如AWS、Azure、Google Cloud Platform、Cloudera、 Hortonworks等。

6. 数据安全与隐私:学习如何保护数据安全,遵守数据隐私法规,如GDPR、CCPA等。

7. 业务理解与沟通:了解业务需求,与业务团队沟通,确保数据分析结果能够满足业务需求。

8. 持续学习与适应:大数据领域不断发展和变化,因此需要持续学习新的技术和工具。

9. 项目管理和团队协作:学习如何管理大数据项目,与团队成员协作,确保项目按时按质完成。

10. 软技能:除了技术技能外,还需要具备良好的沟通、问题解决、批判性思维等软技能。

以上是一些大数据培训可能涉及的主要内容,具体课程和培训内容可能因培训机构和课程而异。

大数据培训需要学习什么?全面解析大数据学习路径

随着大数据时代的到来,掌握大数据技术已成为众多求职者和职场人士的追求。大数据培训课程旨在帮助学员快速掌握大数据相关知识,提升就业竞争力。那么,大数据培训需要学习什么呢?本文将为您全面解析大数据学习路径。

一、Java编程技术

Java编程技术是大数据学习的基础。由于主流的大数据开源框架,如Hadoop、Spark等,其编程都离不开Java。因此,学习Java编程技术是大数据培训的首要任务。

二、Linux命令与Shell编程

大数据开发通常是在Linux环境下进行的。因此,Linux基础操作命令以及Shell编程也是大数据学习的重要组成部分。掌握Linux命令和Shell编程,有助于提高大数据开发效率。

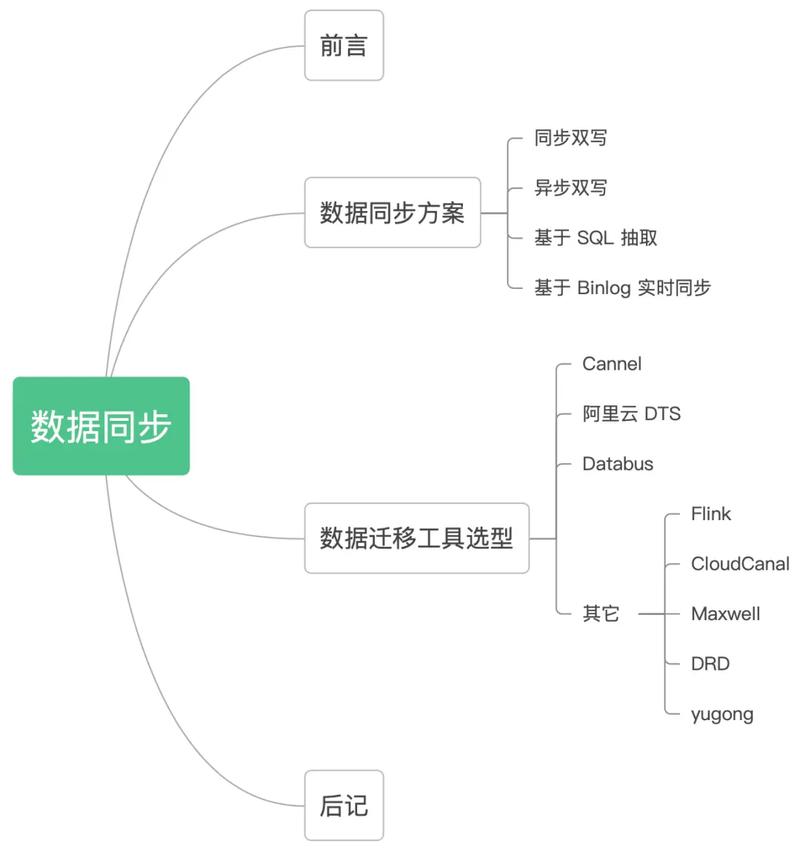

三、大数据相关框架和组件

常用的大数据开发框架有Hadoop、Spark、Storm、Flink等。在学习大数据相关框架和组件时,需要了解其原理和应用场景,以便在实际项目中灵活运用。

Hadoop:作为大数据领域的基石,Hadoop生态圈包含超过20个组件,共同完成面向高度扩展的分布式计算。

Spark:作为MapReduce的替代者,Spark在数据处理速度和易用性方面具有明显优势。

Storm:提供实时处理能力,适用于处理实时数据流。

Flink:具有流处理和批处理能力,适用于复杂的数据处理场景。

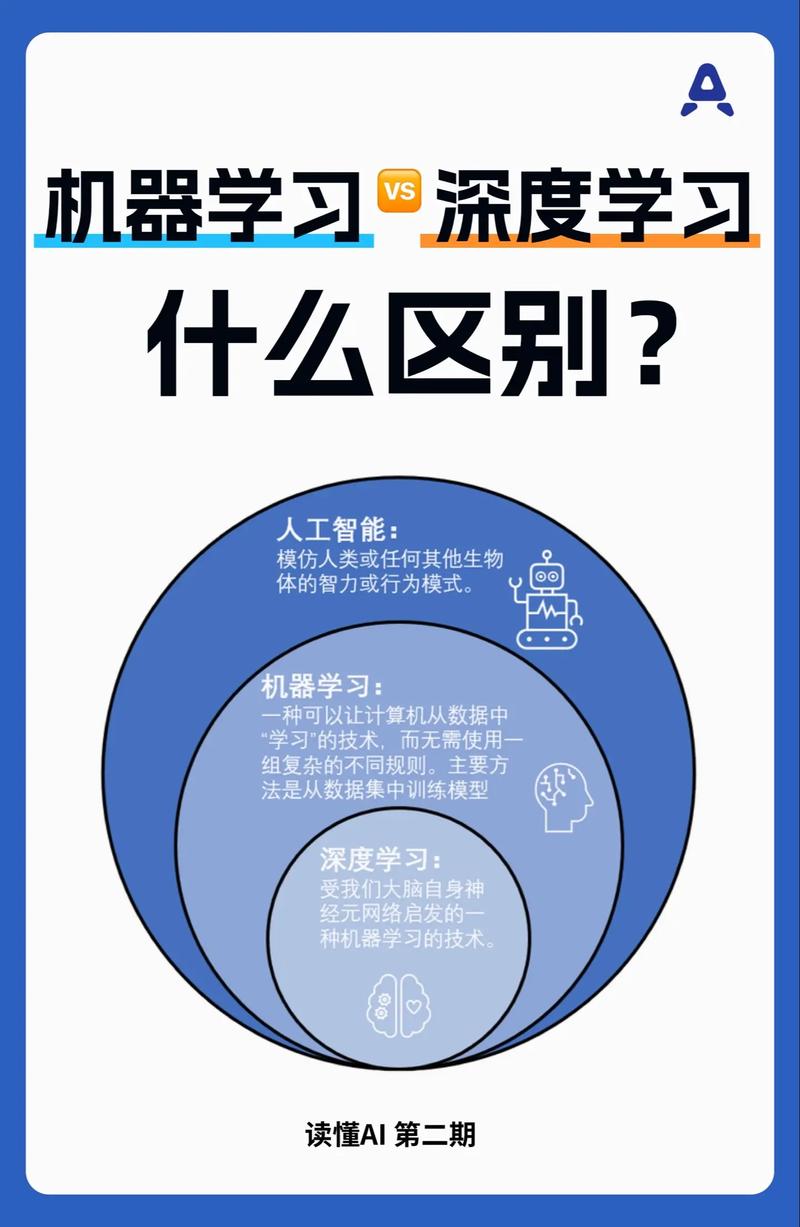

四、数据仓库、数据挖掘、机器学习、人工智能、深度学习

大数据技术体系庞杂,除了上述技术,还包括数据仓库、数据挖掘、机器学习、人工智能、深度学习等。这些技术是大数据领域的核心,对于提升数据分析能力具有重要意义。

五、并行计算与可视化

并行计算和可视化技术是大数据处理过程中的重要环节。掌握这些技术,有助于提高数据处理效率,并使数据分析结果更加直观易懂。

六、项目实战与案例分析

大数据培训不仅要学习理论知识,还要注重实践。通过参与项目实战和案例分析,学员可以更好地理解大数据技术的应用场景,提升实际操作能力。

七、学习路线规划

大数据学习路线规划如下:

第一阶段:Java基础、Linux命令与Shell编程

第二阶段:大数据相关框架和组件(Hadoop、Spark、Storm、Flink等)

第三阶段:数据仓库、数据挖掘、机器学习、人工智能、深度学习等核心知识

第四阶段:并行计算与可视化技术

第五阶段:项目实战与案例分析

大数据培训需要学习的内容丰富多样,涵盖了编程语言、操作系统、框架组件、核心知识、并行计算、可视化等多个方面。通过系统学习,学员可以全面掌握大数据技术,为未来的职业发展奠定坚实基础。