1. Hadoop:Hadoop 是一个开源框架,用于存储和处理大规模数据集。它由 HDFS(Hadoop Distributed File System)和 MapReduce 两个主要组件组成。

2. Spark:Spark 是一个快速、通用的大数据处理引擎。它支持多种编程语言,包括 Scala、Java、Python 和 R,并且可以与 Hadoop 集成。

3. Tableau:Tableau 是一个商业智能工具,用于数据可视化和分析。它允许用户创建交互式仪表板和报告,以便更好地理解数据。

4. Excel:虽然 Excel 不是一个专门的大数据分析工具,但它仍然是一个非常流行的数据分析工具,特别是对于小型数据集。

5. R:R 是一个统计计算和图形的语言和环境。它广泛用于数据分析和统计建模。

6. Python:Python 是一种广泛使用的编程语言,具有丰富的数据分析库,如 Pandas、NumPy 和 Matplotlib。

7. Power BI:Power BI 是微软的一个商业智能工具,用于数据可视化、报告和分析。它支持多种数据源,包括 Excel、SQL Server 和云数据源。

8. SAS:SAS 是一个统计分析和数据管理软件,广泛用于数据挖掘、预测分析和商业智能。

9. MATLAB:MATLAB 是一个用于数值计算、数据分析和可视化的高级编程语言和计算环境。

10. RapidMiner:RapidMiner 是一个数据科学平台,用于数据挖掘、机器学习和文本挖掘。

这些工具可以根据您的具体需求和技能水平选择使用。如果您是初学者,可能需要从简单的工具(如 Excel)开始,然后逐渐过渡到更复杂的大数据分析工具(如 Hadoop 和 Spark)。

大数据分析工具:助力企业挖掘数据价值

随着信息技术的飞速发展,大数据已经成为企业竞争的重要资源。如何有效地进行大数据分析,挖掘数据中的价值,成为企业关注的焦点。本文将介绍几种常见的大数据分析工具,帮助读者了解它们的特点和应用场景。

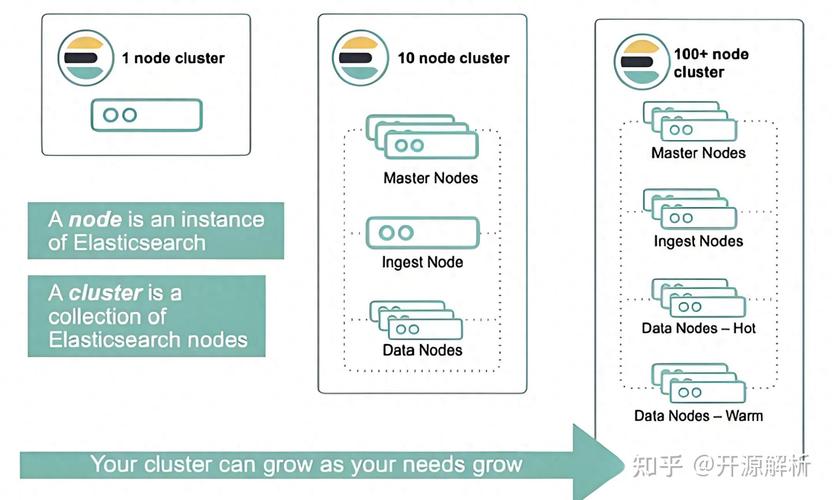

一、Elasticsearch:全文搜索与数据分析利器

Elasticsearch是一个基于Lucene库构建的分布式、开源搜索引擎,它不仅擅长快速的全文搜索,还具备强大的数据存储和分析能力。在大数据分析领域,Elasticsearch可以用于数据探索和预处理,帮助数据科学家发现数据中的潜在模式、异常值以及数据之间的关联关系。

特点:

高效处理大规模数据

支持全文搜索和数据分析

易于扩展和集成

应用场景:

日志分析

搜索引擎

实时监控

二、Apache Spark:快速、通用、可扩展的大数据处理框架

Apache Spark是一个开源的大数据处理框架,它提供了快速、通用、可扩展的数据处理能力。Spark可以处理大规模数据集,并且在内存中进行数据操作,从而实现高速的数据处理和分析。

核心概念:

弹性分布式数据集(RDD):可并行操作的不可变数据集合

转换操作:如map、filter、reduce等

行动操作:如count、collect、save等

应用场景:

数据清洗、转换和数据处理

机器学习、图处理和流处理

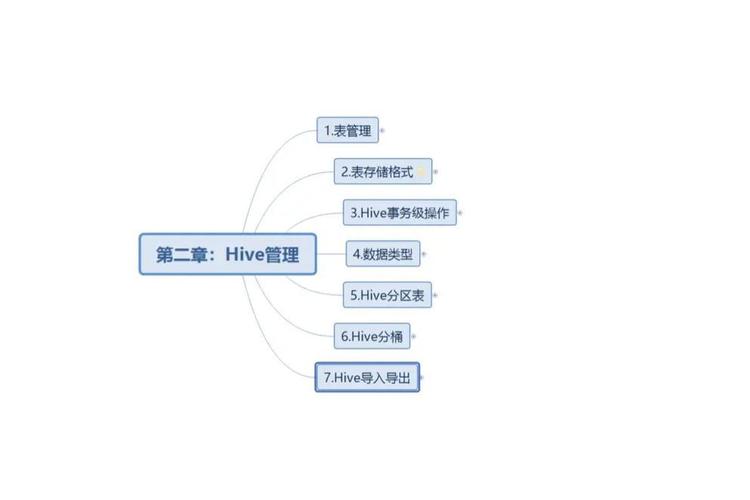

三、Apache Hive:基于Hadoop的数据仓库工具

Apache Hive是一个基于Hadoop的数据仓库工具,用于数据存储、查询和分析,特别适合处理大规模的数据集。它提供了一种类似于SQL的查询语言(HiveQL),可以将结构化数据存储到Hadoop HDFS上,并通过MapReduce、Tez或者Spark来进行查询分析。

特点:

支持SQL查询语言

易于使用和扩展

与Hadoop生态系统兼容

应用场景:

数据仓库建设

ETL任务

大数据分析

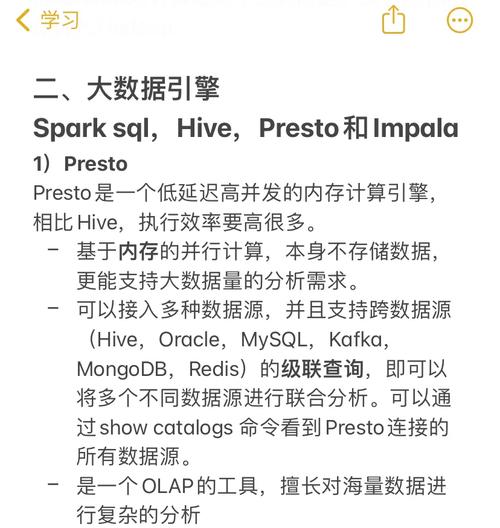

四、Spark SQL Toolkit:轻松解析和查询数据

Spark SQL Toolkit提供了一种现代的方法来与Spark SQL进行交互,类似于SQL数据库代理。它不仅可以处理常规查询,还能在需要时进行错误恢复。这对于任何处理大规模数据并希望提高效率的开发者都是极为有用的。

特点:

简化Spark SQL交互

自动化和优化查询

错误恢复

应用场景:

数据加载与展示

查询和错误恢复

大数据分析工具在帮助企业挖掘数据价值方面发挥着重要作用。本文介绍了Elasticsearch、Apache Spark、Apache Hive和Spark SQL Toolkit等几种常见的大数据分析工具,希望对读者有所帮助。