1. 处理器(CPU):选择高性能的CPU,如Intel Xeon或AMD EPYC系列,以处理大量数据和复杂的计算任务。

2. 内存(RAM):大数据处理通常需要大量的内存,建议配置32GB、64GB或更高,具体取决于数据量和处理需求。

3. 存储:大数据服务器通常需要大容量的存储空间,可以使用高性能的SSD或HDD,或采用RAID配置以提高数据读写速度和可靠性。

4. 网络接口:配置高速网络接口,如10Gbps或更高,以满足大数据传输和通信需求。

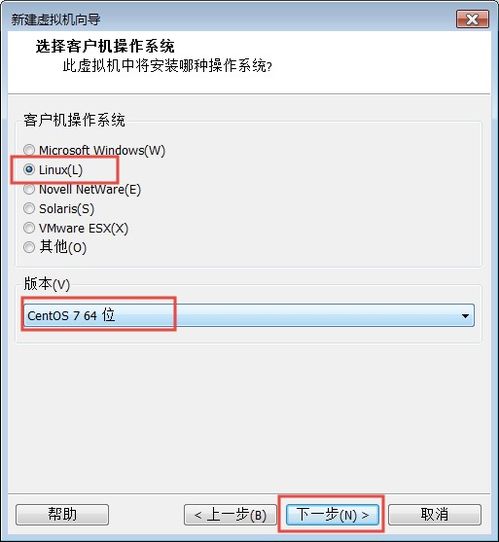

5. 操作系统:选择适合大数据处理的操作系统,如Linux发行版(如CentOS、Ubuntu)。

6. 大数据软件:根据需求选择合适的大数据软件,如Hadoop、Spark、Flink等,以实现数据的存储、处理和分析。

7. 可扩展性:考虑到未来可能的数据增长和处理需求,选择可扩展的服务器硬件和软件配置。

8. 管理和监控:配置服务器管理和监控工具,如Nagios、Zabbix等,以确保服务器稳定运行和及时发现并解决问题。

9. 安全性:配置防火墙、入侵检测系统等安全措施,以保护大数据服务器和数据的安全。

10. 虚拟化:根据需要,可以配置虚拟化技术,如KVM、Xen等,以提高资源利用率和灵活性。

请注意,以上配置仅供参考,具体配置应根据实际需求进行调整。同时,大数据服务器的配置还需要考虑成本、功耗、空间等因素。

大数据服务器配置概述

随着大数据时代的到来,企业对于数据处理和分析的需求日益增长。大数据服务器作为处理海量数据的核心设备,其配置的合理性与高效性直接影响到数据处理的性能和效率。本文将详细介绍大数据服务器的配置要点,帮助读者了解如何构建一个高效的大数据服务器环境。

硬件配置

处理器:选择多核心、高性能的处理器,如Intel Xeon或AMD EPYC系列,以确保数据处理的高效性。

内存:根据数据规模和业务需求,配置足够的内存,一般建议至少128GB,甚至更高。

存储:采用高速、大容量的存储设备,如SSD或NVMe SSD,以提高数据读写速度。同时,考虑使用RAID技术提高数据冗余和可靠性。

网络:配置高速网络,如10Gbps或更高,确保数据传输的流畅性。

操作系统与数据库

操作系统:Linux系统因其稳定性和安全性,是大数据服务器的首选。常见的Linux发行版有CentOS、Ubuntu等。

数据库:根据业务需求选择合适的数据库,如MySQL、PostgreSQL、MongoDB等。对于大数据处理,推荐使用分布式数据库,如HBase、Cassandra等。

大数据处理框架

Hadoop:Hadoop是开源的大数据处理框架,适用于处理大规模数据集。

Spark:Spark是一个快速、通用的大数据处理引擎,支持多种编程语言,适用于实时计算和批处理。

Flink:Flink是一个流处理框架,适用于处理实时数据流。

数据存储与备份

分布式存储:采用分布式存储系统,如HDFS、Ceph等,提高数据存储的可靠性和扩展性。

数据备份:定期进行数据备份,确保数据在发生故障时能够快速恢复。

监控与优化

性能监控:使用性能监控工具,如Nagios、Zabbix等,实时监控服务器性能。

资源优化:根据业务需求,合理分配资源,提高服务器利用率。

系统优化:定期进行系统优化,如更新软件、调整配置等,提高系统稳定性。

大数据服务器配置是一个复杂的过程,需要综合考虑硬件、软件、数据处理框架、数据存储与备份、监控与优化等多个方面。通过合理配置,可以构建一个高效、稳定的大数据服务器环境,为企业提供强大的数据处理能力。