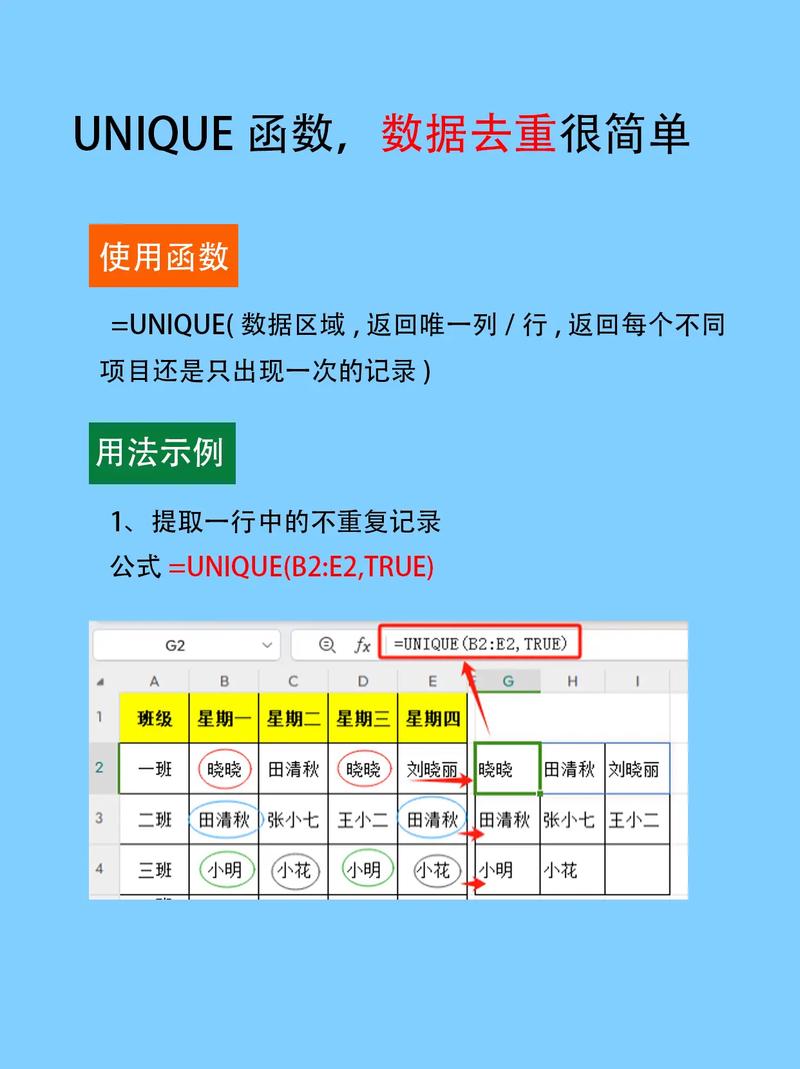

在R语言中,去重通常使用`unique`函数或者`duplicated`函数。以下是这两种方法的简要介绍:

1. `unique`函数:返回数据框、矩阵或向量的唯一值。如果数据框中有重复的行,`unique`函数将返回不重复的行。

2. `duplicated`函数:返回一个逻辑向量,表示数据框、矩阵或向量中的哪些行或元素是重复的。

下面是一个简单的例子,展示如何使用这两种方法去重:

```R 创建一个数据框df 使用unique函数去重unique_df 使用duplicated函数去重 首先,找出重复的行duplicated_rows 显示结果unique_dfdf_without_duplicates```

在这个例子中,`unique_df`将只包含不重复的行,而`df_without_duplicates`也将只包含不重复的行。`duplicated`函数返回的逻辑向量`duplicated_rows`可以用来选择或排除重复的行。

R语言数据去重:高效处理重复数据的技巧

在数据分析过程中,数据去重是一个常见且重要的步骤。重复数据不仅会占用不必要的存储空间,还可能影响分析结果的准确性。本文将详细介绍R语言中处理数据去重的几种方法,帮助您高效地清理数据。

一、数据去重的重要性

数据去重是数据预处理的关键步骤之一。重复数据可能会导致以下问题:

增加数据集的体积,影响存储和计算效率。

导致统计结果的偏差,影响分析结果的准确性。

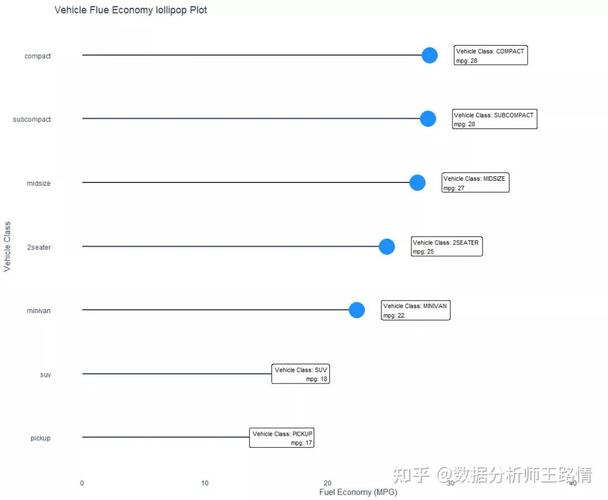

在数据可视化时,重复数据可能会误导观察者。

二、R语言数据去重方法

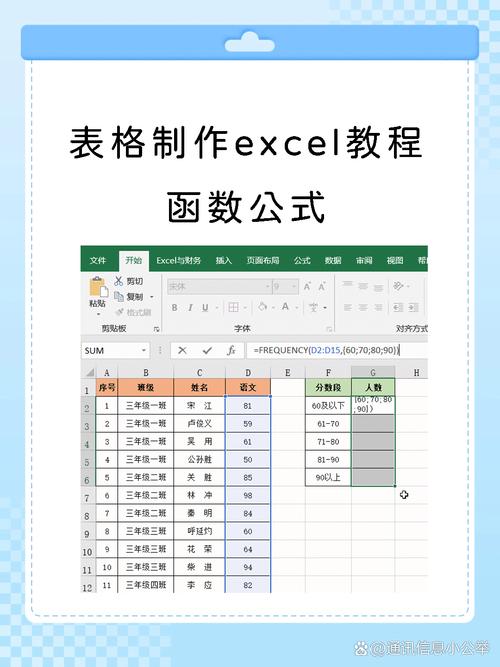

1. 使用unique函数

unique函数是R语言中处理数据去重的基础函数。它可以去除向量、矩阵或数据框中的重复元素。

unique(data_frame)

例如,以下代码将去除数据框df中的重复行:

2. 使用duplicated函数

duplicated函数用于检测数据框中的重复行。它返回一个逻辑向量,指示每行是否为重复行。

duplicated(data_frame)

以下代码将去除数据框df中重复的行:

df_unique

3. 使用dplyr包中的distinct函数

dplyr包是R语言中一个强大的数据处理工具。distinct函数可以去除数据框中的重复行,并保留首次出现的行。

library(dplyr)

distinct(data_frame)

以下代码将去除数据框df中重复的行:

df_unique %

distinct()

4. 使用data.table包中的unique函数

data.table包是R语言中一个高性能的数据处理工具。它的unique函数可以高效地去除数据框中的重复行。

library(data.table)

unique(data_frame)

以下代码将去除数据框df中重复的行:

df_unique

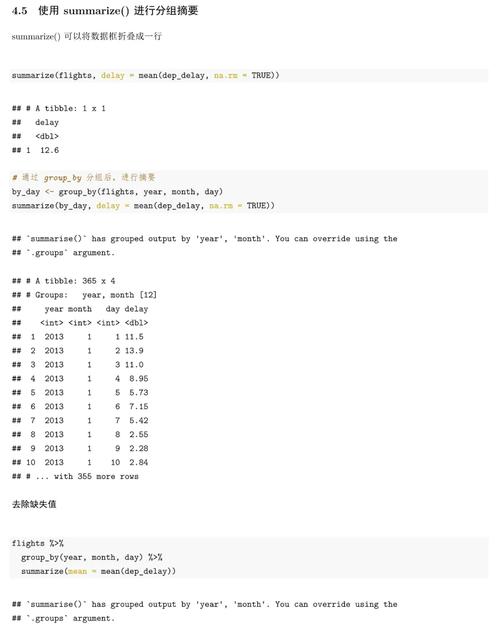

数据去重是数据分析过程中的重要步骤。在R语言中,有多种方法可以实现数据去重,包括unique函数、duplicated函数、dplyr包中的distinct函数以及data.table包中的unique函数。根据实际需求选择合适的方法,可以帮助您高效地清理数据,提高分析结果的准确性。