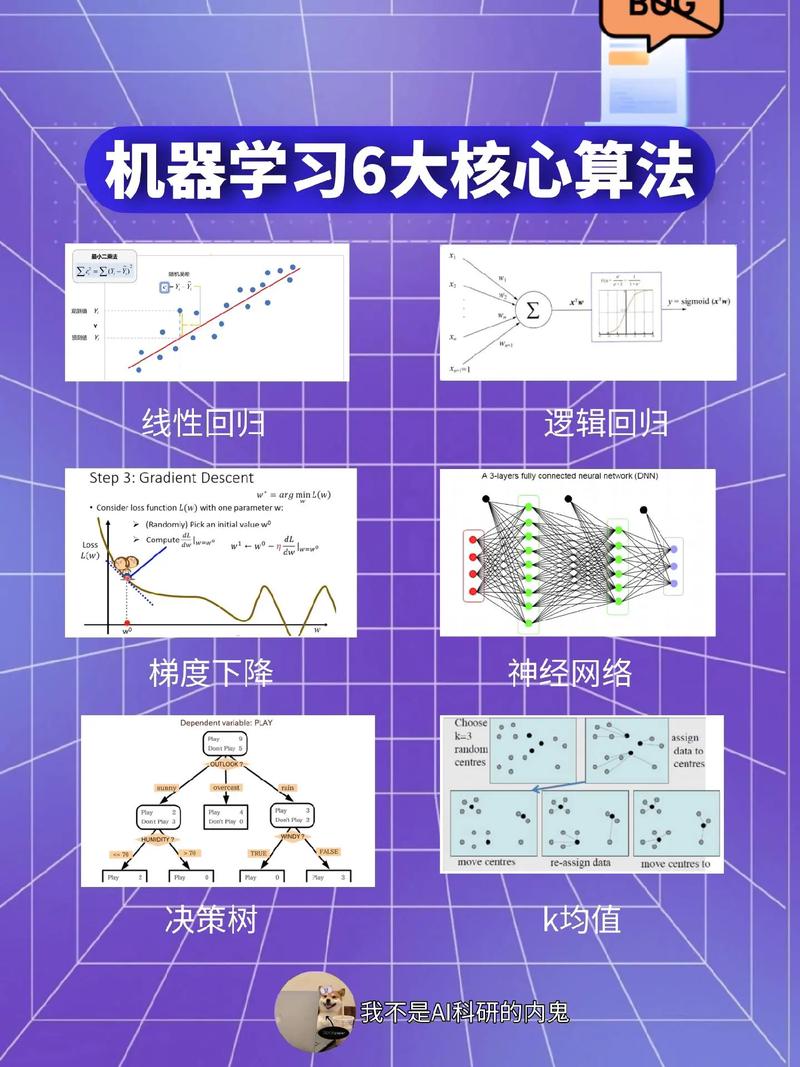

LR(Logistic Regression,逻辑回归)是一种用于二分类的监督学习算法。它通过构建一个逻辑函数(Sigmoid函数)来预测一个样本属于某一类的概率。LR模型的目标是找到最佳的参数,使得模型在训练集上的预测误差最小。

LR模型的主要特点如下:

LR模型在许多领域都有广泛的应用,如垃圾邮件过滤、欺诈检测、疾病诊断等。LR模型也有一些局限性,如它只能处理线性可分的数据,对噪声和异常值敏感等。

在实现LR模型时,通常需要使用梯度下降算法来求解最优参数。梯度下降算法是一种迭代优化算法,通过不断更新参数来最小化损失函数。在LR模型中,损失函数通常使用交叉熵损失函数。

总的来说,LR模型是一种简单而有效的二分类算法,在许多领域都有广泛的应用。它也有一些局限性,需要根据具体问题选择合适的模型。

深入浅出LR机器学习算法:原理、应用与实现

一、LR算法简介

逻辑回归是一种用于解决二分类问题的统计模型,其核心思想是通过逻辑函数(Sigmoid函数)将线性组合的输入特征映射到(0, 1)区间内,从而预测事件发生的概率。在多分类问题中,可以通过softmax函数将概率分布转换为多个类别。

二、LR算法原理

1. 模型假设

逻辑回归假设数据服从伯努利分布,即每个样本只有两个可能的输出值(0或1)。对于二分类问题,输出值0表示负类,输出值1表示正类。

2. 模型参数

逻辑回归模型包含两个参数:权重(weights)和偏置(bias)。权重表示输入特征对输出结果的影响程度,偏置表示模型对输出结果的初始估计。

3. 损失函数

Loss = -[ylog(p) (1-y)log(1-p)]

三、LR算法实现

1. NumPy实现

使用NumPy库实现逻辑回归算法,主要步骤如下:

(1)导入NumPy库和需要的数据。

(2)计算输入特征的平均值和方差,以及目标变量的平均值。

(3)标准化输入特征和目标变量。

(4)初始化权重和偏置。

(5)使用梯度下降法优化模型参数。

(6)计算模型预测概率和损失函数。

(7)评估模型性能。

2. TensorFlow实现

使用TensorFlow库实现逻辑回归算法,主要步骤如下:

(1)导入TensorFlow库和需要的数据。

(2)定义模型结构,包括输入层、隐藏层和输出层。

(3)定义损失函数和优化器。

(4)训练模型。

(5)评估模型性能。

四、LR算法应用

逻辑回归算法在各个领域都有广泛的应用,以下列举一些常见的应用场景:

1. 邮件分类:判断一封邮件是否为垃圾邮件。

2. 情感分析:判断一段文本的情感倾向(正面、负面或中性)。

3. 信用评分:预测客户是否具有还款能力。

4. 医疗诊断:预测疾病的发生概率。

5. 人脸识别:判断两张人脸是否属于同一人。

逻辑回归作为一种经典的机器学习算法,在分类问题中具有广泛的应用。本文介绍了LR算法的原理、实现方法以及应用场景,希望对读者有所帮助。