机器学习小样本问题是指在使用机器学习算法时,数据集的样本数量非常有限的情况。在传统的大数据时代,机器学习算法通常依赖于大量的数据来训练模型,从而提高模型的准确性和泛化能力。在许多实际应用中,我们可能无法获取到大量的数据,或者获取数据的成本非常高昂。

针对小样本问题,研究人员提出了一些解决方案,包括:

1. 数据增强:通过对原始数据进行变换和扩展,生成更多的训练样本,从而增加模型的训练数据量。例如,在图像分类任务中,可以对原始图像进行旋转、缩放、裁剪等操作,生成新的训练样本。

2. 迁移学习:利用在大规模数据集上预训练的模型,将其迁移到小样本任务上。通过调整模型的参数,使其适应新的任务。迁移学习可以有效地利用预训练模型的知识,提高小样本任务的性能。

3. 模型正则化:通过在训练过程中添加正则化项,限制模型的复杂度,从而防止过拟合。正则化技术包括L1正则化、L2正则化、dropout等。

4. 模型集成:将多个模型组合起来,形成一个新的模型。通过集成多个模型,可以提高模型的泛化能力和鲁棒性。

5. 主动学习:在训练过程中,主动选择最有价值的数据进行标注,从而提高训练效率。主动学习可以根据模型的性能,动态地选择最有价值的数据进行标注,从而提高模型的性能。

6. 生成对抗网络(GAN):利用生成对抗网络生成新的训练样本,从而增加训练数据量。GAN可以生成与真实数据分布相似的数据,从而提高模型的性能。

7. 元学习(Meta Learning):元学习是一种学习如何学习的方法,通过训练模型在多个任务上快速适应新任务的能力,从而提高小样本任务的性能。

8. 强化学习:通过与环境交互,学习如何优化策略,从而提高小样本任务的性能。强化学习可以有效地处理小样本问题,因为它可以在有限的样本下进行学习。

9. 深度度量学习:通过学习数据之间的距离,从而提高小样本任务的性能。深度度量学习可以有效地处理小样本问题,因为它可以在有限的样本下进行学习。

10. 深度学习:尽管深度学习通常需要大量的数据,但通过使用深度学习算法,可以有效地处理小样本问题。例如,使用深度学习算法可以自动提取特征,从而提高模型的性能。

总之,机器学习小样本问题是一个具有挑战性的问题,需要采用多种技术来解决。通过数据增强、迁移学习、模型正则化、模型集成、主动学习、生成对抗网络、元学习、强化学习、深度度量学习和深度学习等技术,可以提高小样本任务的性能。

深入浅出小样本学习:机器学习中的高效解决方案

随着大数据时代的到来,机器学习在各个领域得到了广泛应用。在数据量庞大的情况下,如何高效地利用有限的样本数据进行学习,成为了一个重要的研究课题。本文将深入浅出地介绍小样本学习,探讨其在机器学习中的应用及其优势。

一、什么是小样本学习

小样本学习(Few-Shot Learning)是一种在训练样本数量极少的条件下,通过学习样本之间的内在规律,实现对未知样本的预测或分类的机器学习方法。与传统的机器学习方法相比,小样本学习在数据量有限的情况下,能够有效地提高模型的泛化能力。

二、小样本学习的挑战

小样本学习面临着诸多挑战,主要包括以下几个方面:

过拟合:由于样本数量有限,模型容易在训练数据上过度拟合,导致在未知数据上的表现不佳。

泛化能力:在样本数量有限的情况下,如何提高模型的泛化能力,使其能够适应不同的数据分布,是一个关键问题。

计算复杂度:小样本学习通常需要较高的计算复杂度,尤其是在处理高维数据时。

三、小样本学习的方法

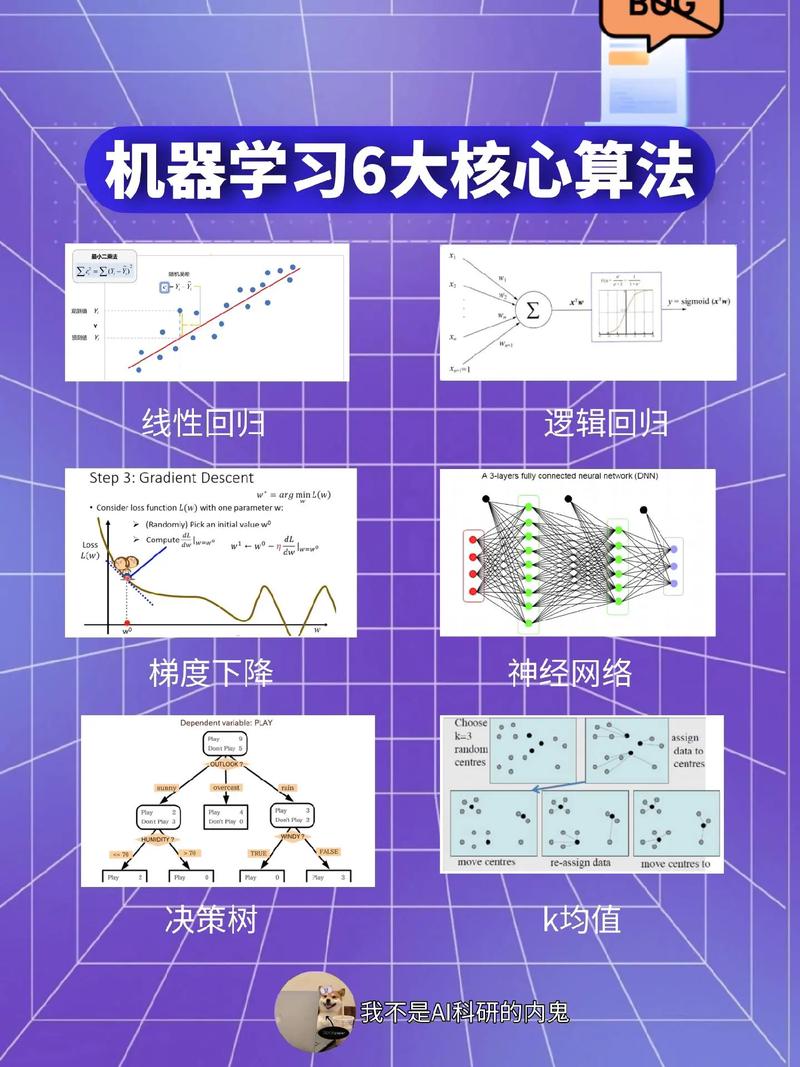

针对小样本学习的挑战,研究者们提出了多种方法,主要包括以下几种:

基于数据增强的方法:通过扩充样本数量,提高模型的泛化能力。例如,使用数据增强技术对少量样本进行扩充,或者利用迁移学习将其他领域的知识迁移到当前任务中。

基于模型改进的方法:通过改进模型结构或优化算法,提高模型的泛化能力。例如,使用深度神经网络、集成学习等方法,或者优化优化算法,如贝叶斯优化、遗传算法等。

基于算法优化的方法:通过优化算法,提高模型的泛化能力。例如,使用元学习、多任务学习等方法,或者优化损失函数,如交叉熵损失、KL散度等。

四、小样本学习的应用

小样本学习在各个领域都有广泛的应用,以下列举一些典型应用场景:

单用户人脸识别:在用户数据量有限的情况下,通过小样本学习技术,实现对用户身份的准确识别。

药物研发:在药物研发过程中,利用小样本学习技术,快速筛选出具有潜力的药物。

推荐系统:在推荐系统中,利用小样本学习技术,提高推荐系统的准确性和个性化程度。

欺诈识别:在金融领域,利用小样本学习技术,识别潜在的欺诈行为。

小样本学习作为一种高效的机器学习方法,在数据量有限的情况下,能够有效地提高模型的泛化能力。随着研究的不断深入,小样本学习将在更多领域发挥重要作用,为人工智能的发展提供有力支持。