1. 向量:向量是机器学习中的基本数据结构,它通常表示数据点、特征或参数。向量可以用行向量或列向量表示,并且可以进行加法、减法、标量乘法等基本运算。

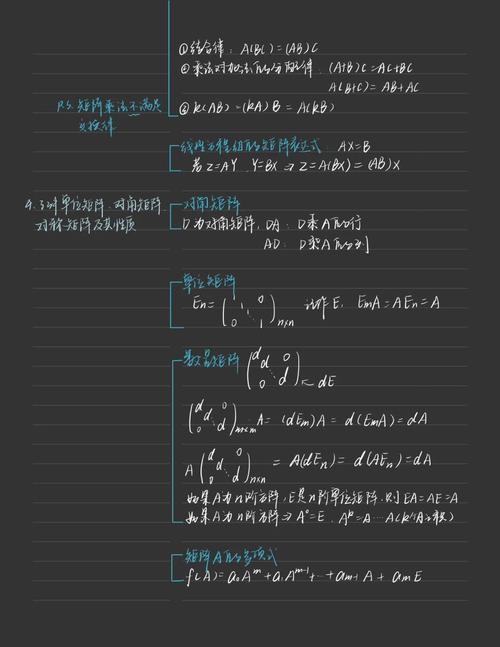

2. 矩阵:矩阵是由向量组成的二维数组,它通常用于表示数据集、参数矩阵或变换矩阵。矩阵可以进行加法、减法、标量乘法、矩阵乘法等基本运算。

3. 线性变换:线性变换是机器学习中的核心概念之一,它将一个向量或矩阵映射到另一个向量或矩阵。线性变换可以通过矩阵乘法来实现,并且具有线性和可逆的性质。

4. 特征值和特征向量:特征值和特征向量是矩阵的重要属性,它们可以用于描述矩阵的性质和进行矩阵分解。在机器学习中,特征值和特征向量可以用于主成分分析(PCA)、奇异值分解(SVD)等降维技术。

5. 正定矩阵:正定矩阵是机器学习中的另一个重要概念,它具有一些特殊的性质,如所有的特征值都是正数。正定矩阵在优化问题、协方差矩阵等场景中有着广泛的应用。

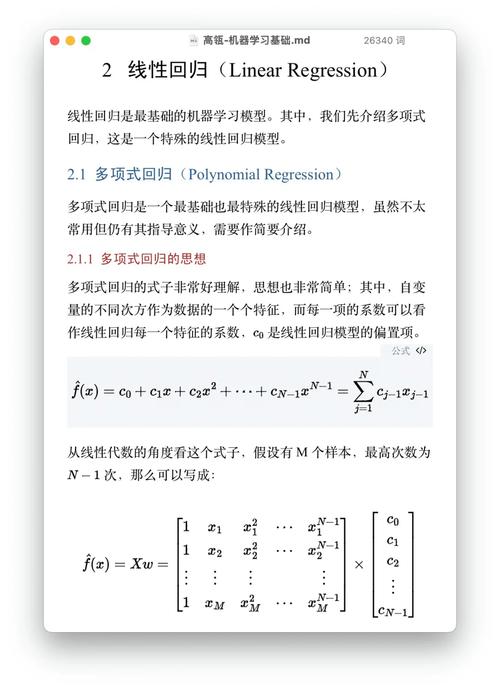

6. 线性方程组:线性方程组是机器学习中的另一个基本概念,它可以用矩阵和向量的形式表示。线性方程组可以用于求解机器学习模型中的参数,如线性回归、支持向量机等。

以上只是线性代数在机器学习中的几个基本概念,实际上线性代数在机器学习中的应用非常广泛,包括但不限于特征提取、降维、分类、回归、聚类等。因此,掌握线性代数的基本概念和运算对于理解和应用机器学习算法非常重要。

机器学习中的线性代数:理解与运用

机器学习作为人工智能领域的一个重要分支,其核心在于从数据中学习规律,并用于预测或决策。在这个过程中,线性代数扮演着至关重要的角色。线性代数为机器学习提供了强大的数学工具,帮助我们更好地理解和处理数据。本文将深入探讨线性代数在机器学习中的应用,帮助读者建立对这一领域的全面认识。

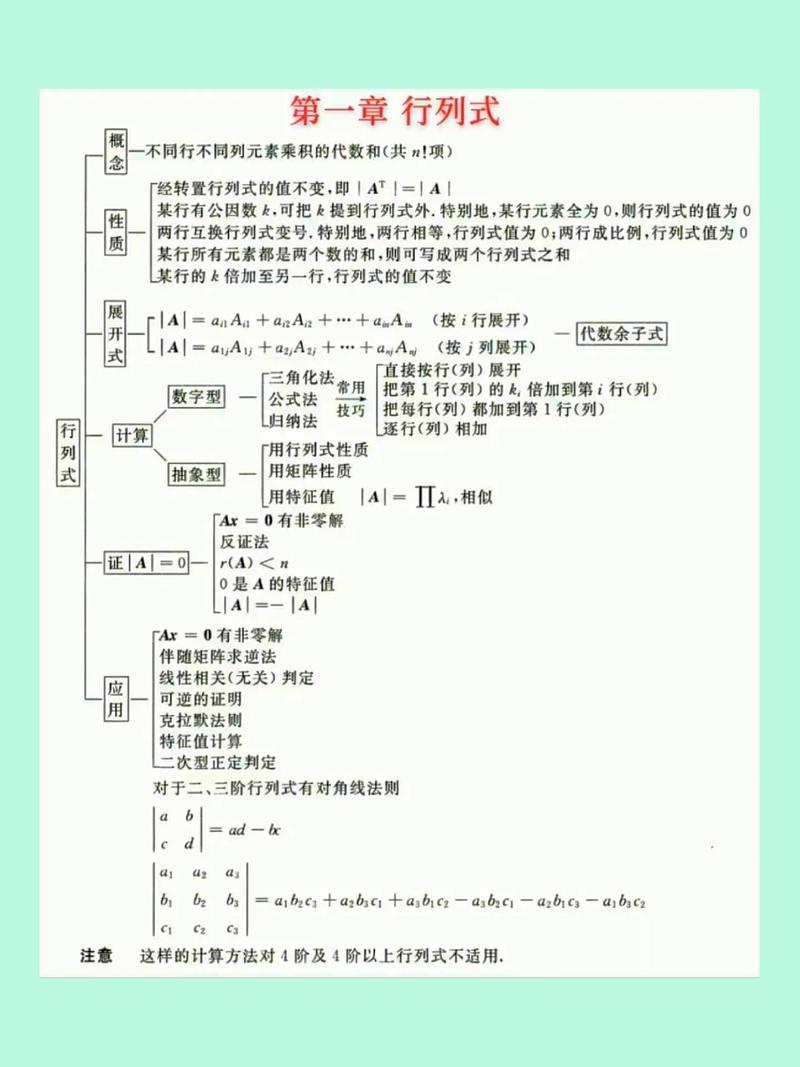

一、线性代数基础

线性代数是研究向量、矩阵及其运算的数学分支。在机器学习中,线性代数的基本概念包括向量、矩阵、行列式、特征值和特征向量等。

二、向量与矩阵

向量是线性代数中的基本元素,可以表示为有序数组的集合。在机器学习中,向量常用于表示数据。矩阵是由多个向量组成的二维数组,可以表示数据之间的关系。

在机器学习中,矩阵运算主要包括矩阵加法、矩阵乘法、矩阵转置等。这些运算对于数据预处理、特征提取和模型训练等环节至关重要。

三、特征值与特征向量

特征值和特征向量是矩阵的重要属性。特征值表示矩阵对向量的伸缩程度,特征向量表示矩阵对向量的方向。在机器学习中,特征值和特征向量常用于降维、特征提取和模型优化等环节。

例如,奇异值分解(SVD)是一种常用的矩阵分解方法,可以将矩阵分解为若干个特征值和特征向量的乘积。SVD在图像处理、文本分析等领域有着广泛的应用。

四、线性代数在机器学习中的应用

线性代数在机器学习中的应用主要体现在以下几个方面:

1. 数据预处理

在机器学习中,数据预处理是至关重要的环节。线性代数中的矩阵运算可以帮助我们进行数据标准化、归一化、缺失值处理等操作,提高模型的性能。

2. 特征提取与降维

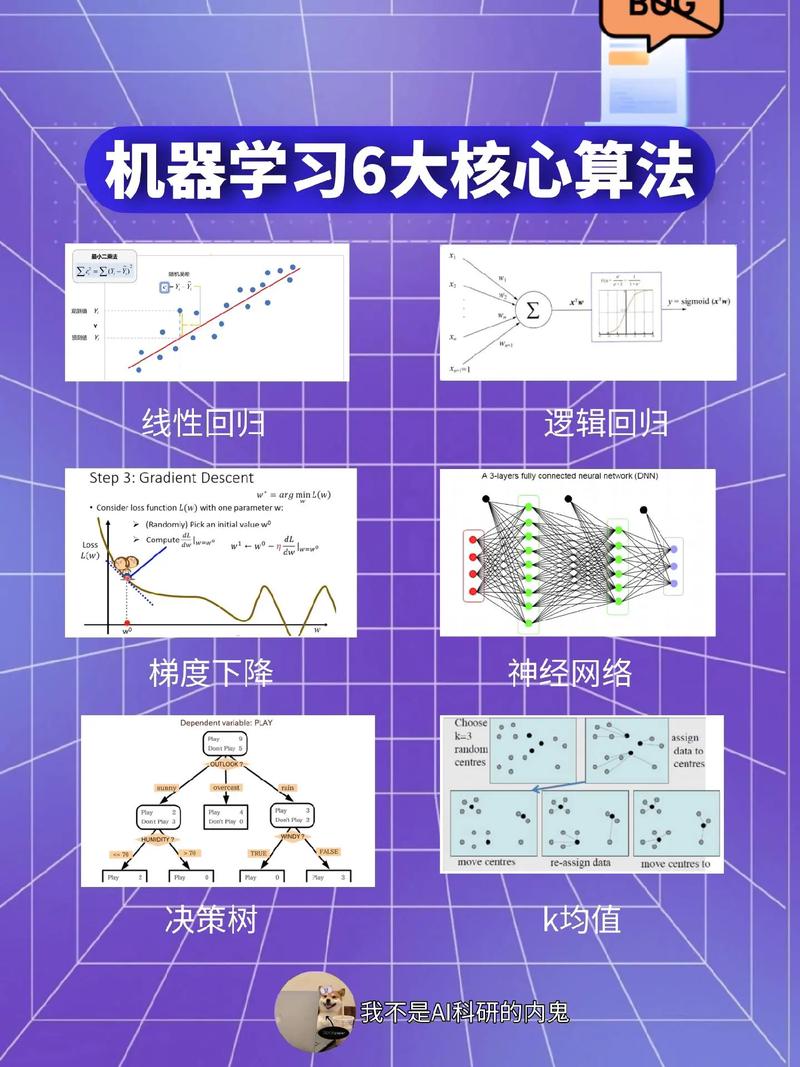

特征提取和降维是机器学习中的关键技术。线性代数中的主成分分析(PCA)是一种常用的降维方法,可以将高维数据投影到低维空间,同时保留大部分信息。

3. 模型训练与优化

在机器学习中,模型训练和优化是核心环节。线性代数中的矩阵运算可以帮助我们进行梯度下降、牛顿法等优化算法的计算,提高模型的准确性和泛化能力。

五、线性代数学习资源推荐

《线性代数及其应用》(David C. Lay)

《线性代数》(丘维声)

在线课程:Coursera、edX、网易云课堂等平台上的线性代数课程