机器学习中的降维是指通过减少数据集的维度来简化数据集的过程。降维的主要目的是提高模型的性能,减少计算资源的需求,以及提高模型的解释性。降维技术通常在以下情况下使用:

1. 减少特征数量:当数据集包含大量特征时,使用降维技术可以减少特征数量,从而减少模型的复杂性。

2. 提高模型性能:通过去除无关或冗余的特征,降维可以提高模型的性能。

3. 减少计算资源:降维可以减少模型的计算需求,从而减少计算资源的使用。

4. 提高模型的可解释性:降维可以减少模型的复杂性,使其更容易解释和理解。

5. 提高模型的泛化能力:通过去除噪声和冗余特征,降维可以提高模型的泛化能力。

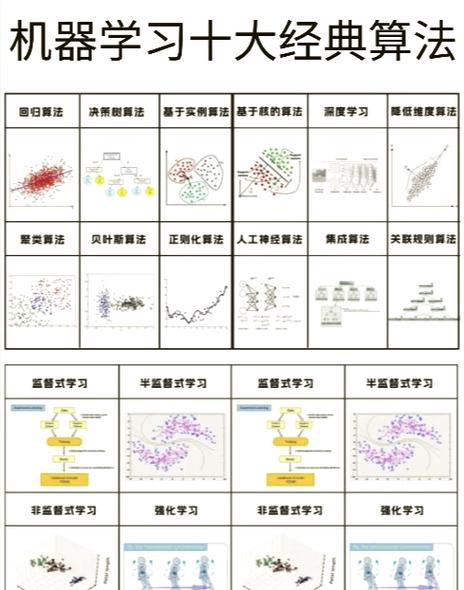

降维技术可以分为以下两类:

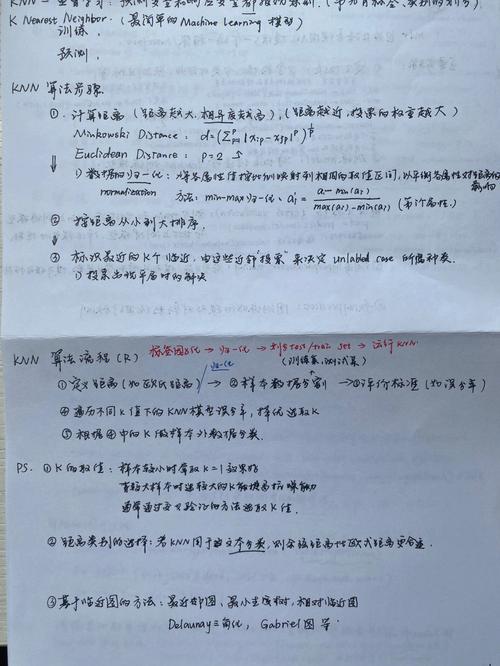

1. 特征选择:特征选择是指从原始特征集中选择出一部分特征,这些特征能够保留原始数据集的大部分信息。特征选择的方法包括:

基于统计的方法:例如,可以使用方差分析(ANOVA)来选择与目标变量相关的特征。 基于模型的方法:例如,可以使用决策树或随机森林来选择重要的特征。 基于启发式的方法:例如,可以使用信息增益或增益率来选择特征。

2. 特征提取:特征提取是指通过创建新的特征来表示原始特征集,这些新特征能够保留原始数据集的大部分信息。特征提取的方法包括:

主成分分析(PCA):PCA是一种无监督的降维技术,它通过将原始特征集投影到主成分上,从而减少特征数量。 线性判别分析(LDA):LDA是一种有监督的降维技术,它通过最大化类内方差和最小化类间方差来选择特征。 自编码器:自编码器是一种无监督的深度学习技术,它通过学习数据集的表示来减少特征数量。

降维技术在机器学习中扮演着重要的角色,它可以帮助我们更好地理解和处理数据集,提高模型的性能和泛化能力。

机器学习中的降维技术:原理与应用

随着大数据时代的到来,高维数据在各个领域得到了广泛应用。高维数据也带来了诸多挑战,如计算复杂度高、数据稀疏性增加、可解释性降低等。为了解决这些问题,降维技术在机器学习中扮演着至关重要的角色。本文将介绍机器学习中的降维技术,包括其原理、常用方法以及在实际应用中的优势。

一、降维技术的原理

降维技术旨在将高维数据映射到低维空间,同时保留数据的主要特征。其核心思想是:高维数据往往存在冗余信息,通过降维可以去除这些冗余信息,从而降低数据的复杂度。

二、常用降维方法

1. 主成分分析(PCA)

主成分分析是一种经典的线性降维方法,通过求解协方差矩阵的特征值和特征向量,将数据投影到低维空间。PCA在处理线性可分的数据时效果较好,但无法处理非线性数据。

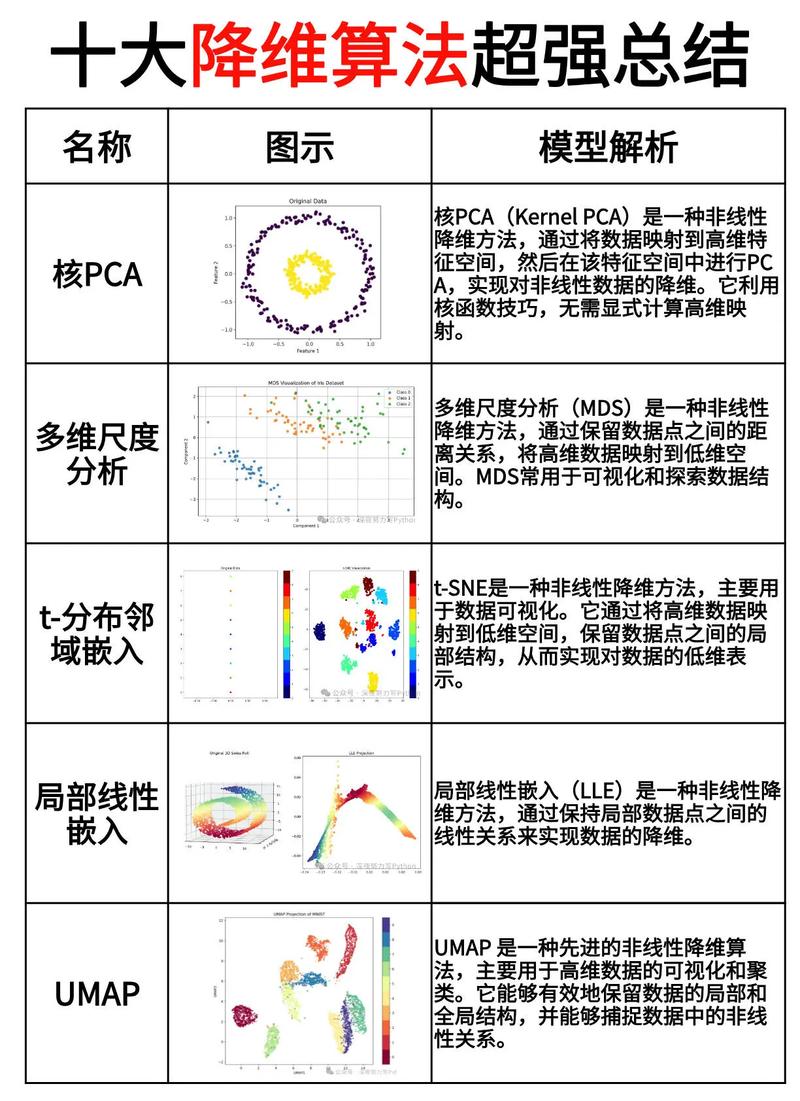

2. 非线性降维方法

对于非线性数据,常用的降维方法包括局部线性嵌入(LLE)、等距映射(Isomap)和t-SNE等。这些方法通过保留数据点之间的局部几何结构,将高维数据映射到低维空间。

3. 基于矩阵分解的降维方法

奇异值分解(SVD)和主成分分析(PCA)都是基于矩阵分解的降维方法。SVD通过分解协方差矩阵,提取数据的主要特征,从而实现降维。PCA是SVD的一种特殊情况,当协方差矩阵为正定矩阵时,SVD和PCA的结果相同。

三、降维技术的应用

1. 数据可视化

降维技术可以帮助我们更好地理解高维数据,通过将数据映射到低维空间,可以直观地展示数据之间的关系,从而实现数据可视化。

2. 机器学习模型训练

在机器学习模型训练过程中,降维技术可以降低模型的复杂度,提高模型的训练速度和泛化能力。此外,降维还可以帮助去除数据中的噪声,提高模型的准确性。

3. 特征选择

降维技术可以帮助我们识别数据中的关键特征,从而实现特征选择。通过选择关键特征,可以提高模型的性能,降低计算复杂度。

降维技术在机器学习中具有广泛的应用,可以帮助我们解决高维数据带来的挑战。本文介绍了降维技术的原理、常用方法以及在实际应用中的优势。在实际应用中,应根据具体问题选择合适的降维方法,以提高模型的性能和可解释性。