统计学习方法和机器学习是两个密切相关但又有所区别的概念。下面是对这两个概念的详细介绍及其关系:

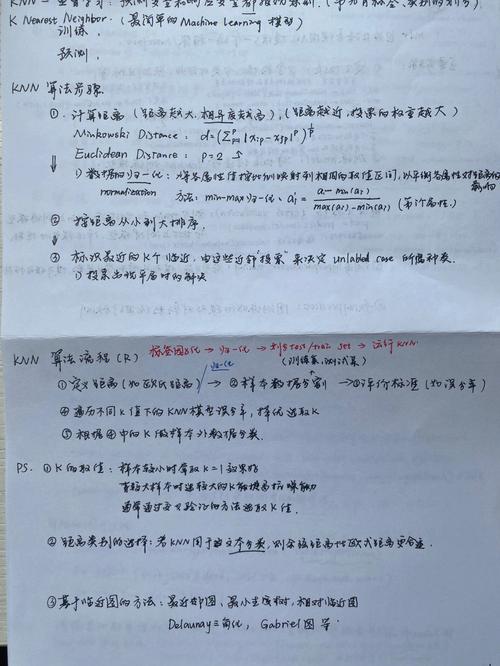

统计学习方法统计学习方法主要关注如何从数据中学习规律和模式,以解决实际问题。李航老师编写的《统计学习方法》全面系统地介绍了统计学习的主要方法,特别是监督学习方法。这些方法包括感知机、k近邻法、朴素贝叶斯法、决策树、逻辑斯谛回归与支持向量机、提升方法、EM算法、隐马尔可夫模型和条件随机场等。

统计学习方法的特点是:1. 理论基础深厚:涉及高等数学、线性代数、数值分析、凸优化理论和矩阵论等知识。2. 应用广泛:适用于文本数据挖掘、信息检索及自然语言处理等领域。

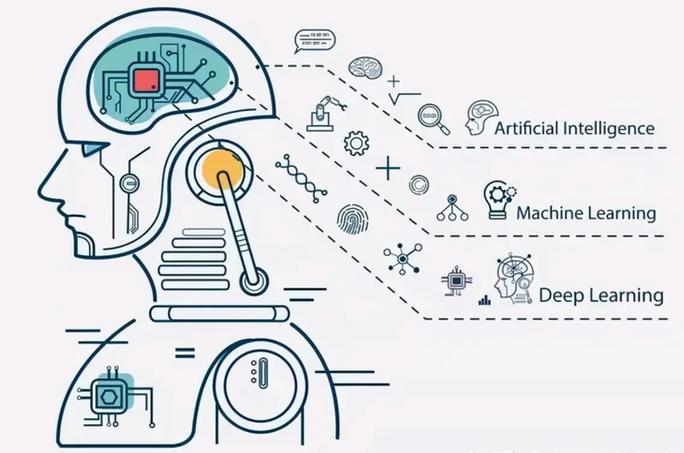

机器学习机器学习是人工智能的一个分支,它使计算机能够从数据中学习并做出决策。机器学习的研究主要分为两类:1. 传统机器学习:研究学习机制,模拟人的学习过程。2. 大数据环境下的机器学习:研究如何有效利用巨量数据,从数据中提取有价值的信息。

统计学习方法与机器学习的关系统计学习方法和机器学习之间有着紧密的联系,但也存在一些区别:1. 联系: 理论基础:统计学习方法和机器学习都依赖于统计学和数学的理论基础,例如概率论、线性代数和优化理论。 应用场n总的来说,统计学习方法和机器学习是相辅相成的,它们共同推动了数据科学和人工智能的发展。在实际应用中,两者经常结合使用,以发挥各自的优势。

深入浅出统计学习方法在机器学习中的应用

随着信息技术的飞速发展,机器学习已经成为人工智能领域的研究热点。统计学习方法作为机器学习的基础,其在各个领域的应用日益广泛。本文将深入浅出地介绍统计学习方法在机器学习中的应用,帮助读者更好地理解这一重要领域。

一、什么是统计学习方法?

统计学习方法是一种基于概率论和数理统计理论,通过分析数据特征,建立数学模型,从而对未知数据进行预测或分类的方法。其主要目的是从数据中提取规律,为实际问题提供解决方案。

二、统计学习方法在机器学习中的应用

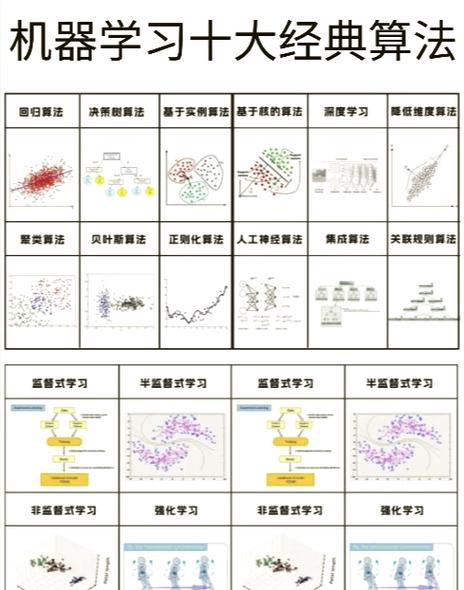

1. 监督学习

监督学习是统计学习方法在机器学习中最常见的一种应用。其主要任务是通过已知的输入和输出数据,学习一个映射规则,从而对新的输入数据进行预测。常见的监督学习方法包括线性回归、逻辑回归、支持向量机(SVM)等。

2. 无监督学习

无监督学习是另一种重要的统计学习方法,其主要任务是从未标记的数据中寻找规律,对数据进行聚类或降维。常见的无监督学习方法包括K-means聚类、主成分分析(PCA)、自编码器等。

3. 强化学习

强化学习是一种通过与环境交互,不断学习最优策略的统计学习方法。其主要应用场景包括游戏、机器人控制、推荐系统等。常见的强化学习方法包括Q学习、深度Q网络(DQN)等。

三、线性回归模型

线性回归是一种经典的统计学习方法,主要用于回归问题。其基本思想是建立输入变量与输出变量之间的线性关系,从而预测新的输入数据对应的输出值。线性回归模型包括简单线性回归和多元线性回归两种形式。

1. 简单线性回归

简单线性回归模型只包含一个自变量和一个因变量,其数学表达式为:y = β0 β1x ε,其中y为因变量,x为自变量,β0和β1为模型参数,ε为误差项。

2. 多元线性回归

多元线性回归模型包含多个自变量和一个因变量,其数学表达式为:y = β0 β1x1 β2x2 ... βnxn ε,其中n为自变量的个数。

四、K-means聚类算法

K-means聚类是一种常用的无监督学习方法,其主要思想是将数据集划分为K个簇,使得每个簇内的数据点尽可能接近,而不同簇之间的数据点尽可能远离。K-means聚类算法的具体步骤如下:

1. 随机选择K个数据点作为初始聚类中心。

2. 将每个数据点分配到最近的聚类中心所在的簇。

3. 更新聚类中心,使其成为对应簇内所有数据点的均值。

4. 重复步骤2和3,直到聚类中心不再发生变化或达到预设的迭代次数。

五、决策树

决策树是一种常用的监督学习方法,其主要思想是通过一系列的决策规则,将数据集划分为不同的子集,从而实现对数据的分类或回归。决策树算法包括以下步骤:

1. 选择一个特征作为分割依据。

2. 根据该特征将数据集划分为两个子集。

3. 对每个子集重复步骤1和2,直到满足停止条件。

4. 将最终得到的决策规则组合起来,形成一棵决策树。

六、集成学习

集成学习是一种将多个学习器组合起来,以提高预测准确率和泛化能力的统计学习方法。常见的集成学习方法包括Bagging、Boosting和Stacking等。

1. Bagging

Bagging是一种通过随机选择训练数据集的子集,对每个子集训练一个学习器,然后将这些学习器的预测结果进行投票或平均,得到最终预测结果的方法。

2. Boosting

Boosting是一种通过迭代地训练多个学习器,每次迭代都关注前一次迭代预测错误的样本,从而提高模型对少数类的预测能力的方法。

3. Stacking

Stacking是一种将多个学习